In diesem Blog schreibe ich regelmäßig zu Themen rund um AI/KI, Voice & Alexa. Zum Teil verweisen die Texte weiter auf englische Artikel oder Beispielprojekte in meinem Github-Account.

Private Prompts in der PC Welt

Die PC Welt hat dem Thema Private Prompts einen eigenen Artikel mit dem Titel “Private Prompts: Nutzen Sie KI-Tools ohne Preisgabe Ihrer Daten“ gewidmet. Besonders hervorgehoben wird der Anwendungsablauf: Daten definieren, markieren, maskieren, in der KI verwenden und danach zurückkonvertieren.

Private Prompts im Deutschlandfunk / DLF

In einem Interview durfte ich im Rahmen des DLF Podcasts “KI Verstehen“ meine Lösung “Private Prompts“ vorstellen. Der Titel der Sendung lautet “Warum man ChatGPT nicht alles erzählen sollte“.

Private Prompts in “zm” (Zahnärztliche Mitteilungen)

Die Berichterstattung zieht Kreise: in der Zeitschrift zm ist ein weiterer Artikel über Private Prompts erschienen. Der Beitrag steht auf Seite 73 im PDF.

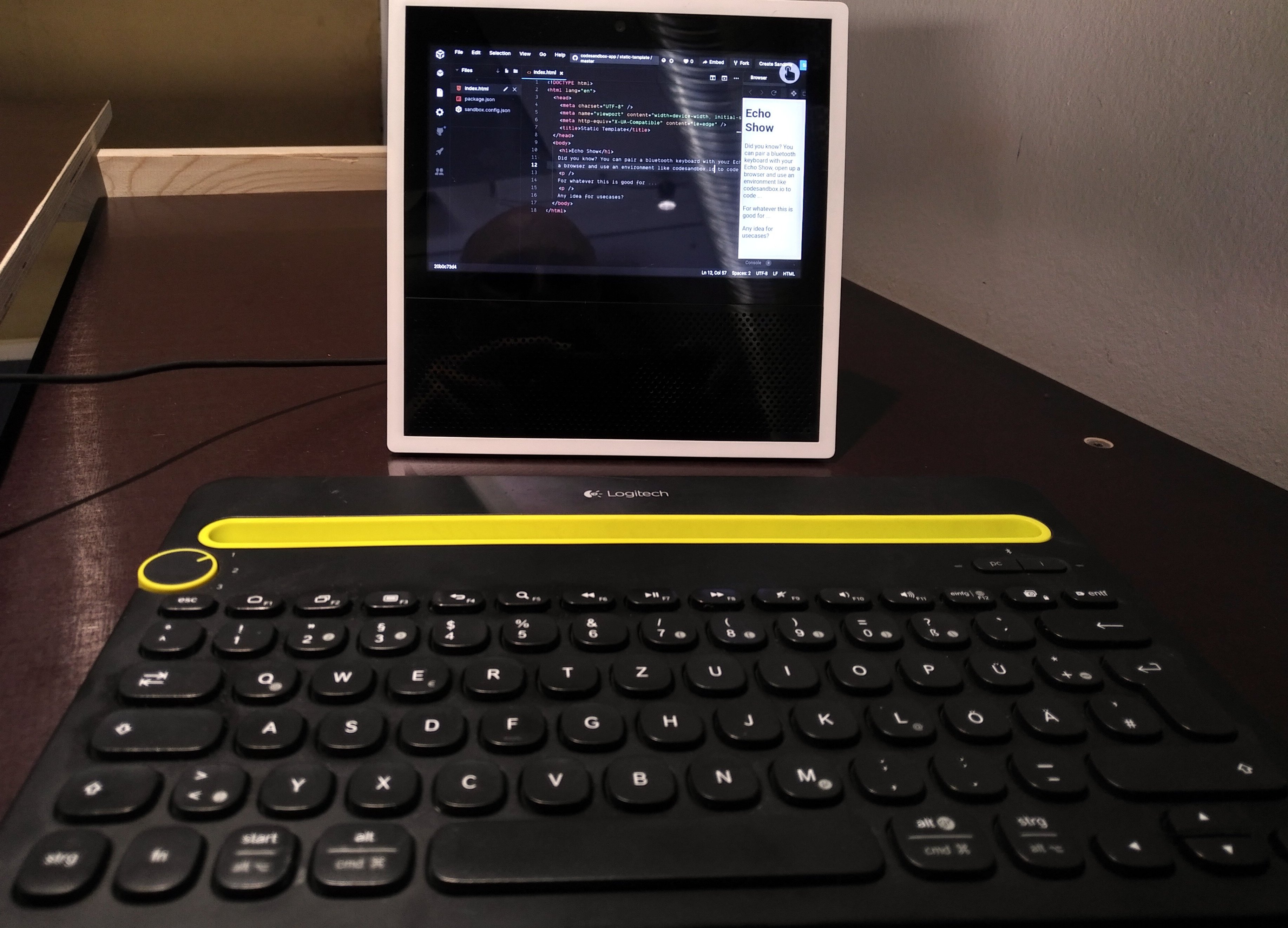

Erste Begegnung mit Alexa+ und Emerson Sklar

Vor wenigen Tagen hatte ich die besondere Gelegenheit, mich in München persönlich mit Emerson Sklar, dem Chief Evangelist für Alexa bei Amazon, auszutauschen. Wir kennen uns online schon länger, aber sein Besuch in München machte eine persönliche Begegnung möglich. Er hatte einen echten Echo Show 21 im Gepäck, so dass wir nicht nur diskutieren, sondern auch konkret ausprobieren konnten, was uns mit der nächsten Evolutionsstufe von Alexa bevorsteht.

Dieses Gespräch war weit mehr als ein kurzer Austausch über neue Features. Es war ein tiefer technischer Einblick in die strategische Neuausrichtung von Alexa, insbesondere im Hinblick auf generative KI, Interaktionsdesign und Entwicklerfreundlichkeit.

Programmiermodelle

Die größte Veränderung aus der Entwicklerperspektive: Alexa+ ersetzt das bekannte Intent-Modell durch ein deklaratives Skill-Modell. Statt „Sample Utterances“ und „Custom Intents“ definieren Entwickler künftig Master Prompts, die den Zweck eines Skills beschreiben – ergänzt durch repräsentative Dialogbeispiele und optionale API-Deklarationen.

Prototypen sind damit schnell gebaut - wie man dann am Feinschliff arbeiten kann, das wird man sehen müssen.

Emerson stellte noch zwei alternative Entwicklungsmodelle vor:

Nova Act: KI-gestützte Webinteraktionen

Nova Act präsentiert sich als eine Art Assistenzmodell, das Webinteraktionen wie das Ausfüllen von Formularen, das Klicken auf Schaltflächen oder das Navigieren durch Seiteninhalte eigenständig durchführen kann.

Das Ziel: Alexa soll in der Lage sein, Services zu nutzen, für die es keine native API gibt. Das öffnet völlig neue Anwendungsfelder – etwa für kleine Anbieter oder Legacy-Systeme.

Agent-Based Execution Model

Bei diesem Modell gehr es noch einen Schritt weiter: Alexa+ kann autonome Agenten einsetzen, die komplexe Aufgaben mehrstufig und selbstständig abarbeiten können – mit interner Planung, Zwischenschritten, Bedingungsprüfungen und ggf. Rückfragen an den Nutzer.

Für uns Entwickler bedeuten diese neuen Ansätze vor allem Abschied nehmen von dem Programmiermodell, das wir seit Jahren kennen und eine völlig neue Denkweise beim Skill-Design.

Klassische Skills werden wir nicht migrieren können, alle angekündigten Programmiermodelle unterscheiden sich grundsätzlich von dem, was wir früher verwendet haben.

Migration bedeutet de facto Neuentwicklung.

Wichtig: klassische Skills wird man aber weiter über ihren Invocation Name aufrufen können.

Lokalisierung: Mehr als nur Sprache übersetzen

Wann werden wir Alexa+ in Deutschland sehen? Emerson hielt sich hier bedeckt, machte aber deutlich, dass wir mit einer ähnlichen Reihenfolge rechnen können wie bei der internationalen Einführung von Alexa.

Er machte dabei klar, dass Alexa+ nicht einfach nur übersetzt wird – die Systeme müssen stets auch kulturell angepasst werden. Beispiel: Ein Skill, der in den USA gut funktioniert, braucht in Deutschland nicht nur eine andere Sprache, sondern auch andere Erwartungen an Tonalität, Direktheit und Struktur. Aus diesem Grund macht eine Einführung für die Locale GB auch kaum weniger Arbeit als für FR.

Nutzerprofile, Personalisierung & Kontinuität

Wir werden Alexa+ in der Verwendung als wesentlich „kontextbewusster“ erleben. Emerson bestätigte, dass Skills künftig mit Nutzerprofilen arbeiten können – also zwischen verschiedenen Familienmitgliedern, Vorlieben oder Gerätekontexten unterscheiden.

Beispiel: Wenn ich als Nutzer regelmäßig vegetarische Rezepte aufrufe, wird Alexa sich das merken und mir im passenden Kontext gezielt solche Inhalte vorschlagen.

Konversationen können auch auf einem anderen Gerät fortgesetzt werden. Der Nutzer muss nicht immer wieder von vorne beginnen.

Diese kontinuierliche Personalisierung macht Skills relevanter und nützlicher im Alltag.

Alexa.com wird zur zentralen Verwaltungsoberfläche

Mit dem Start von Alexa+ wird alexa.com zur zentralen Plattform für die Verwaltung aller Alexa-bezogenen Inhalte ausgebaut – einschließlich Interaktionen, Personalisierung, verknüpfter Dienste und möglicherweise auch Skill-Konfigurationen.

Amazon hat bereits bestätigt, dass sowohl alexa.com als auch die aktualisierte Alexa-App eine Schlüsselrolle im neuen Ökosystem spielen werden. Nutzer können dort Sprachinteraktionen einsehen, Einstellungen anpassen, Profile verwalten und auf per Sprache gestartete Dienste oder Dokumente zugreifen. Ein Beispiel: Eine per Sprache begonnene Lebensmittelbestellung auf einem Echo-Gerät kann später am Desktop weiterbearbeitet werden.

Diese Zentralisierung ist ein logischer Schritt. Sie reduziert Reibungsverluste, verbessert die Geräte-übergreifende Bedienbarkeit und schafft Transparenz – ein häufig geäußerter Wunsch von Nutzern und Entwicklern. Aus meiner Sicht wird Alexa damit nicht nur als Sprachassistent, sondern als plattformübergreifender, multimodaler Alltagsbegleiter weiterentwickelt.

Zertifizierung & Qualitätssicherung

Ein wichtiges Thema für viele Entwickler ist Zertifizierung:

Laut Emerson wird Amazon das Review-Verfahren verschärfen – aus Kundensicht im positiven Sinne. Alexa+ soll nur solche Skills hervorheben, die klaren Mehrwert bieten, stabil funktionieren und vertrauenswürdig sind. Wir wissen alle, dass viele unsinnige Skills den Ruf von Alexa eher beschädigen, als dass sie das Angebot nutzbringend erweitern.

Das Ziel ist natürlich Vertrauen. Alexa+ soll verlässlicher und professioneller wirken – sowohl für Endnutzer als auch für Unternehmen.

Problem für Entwickler: es kann in Zukunft noch häufiger passieren, dass wir viel Arbeit in einen Skill investieren und dieser dann abgelehnt wird. Aktuell ist keine Möglichkeit vorgesehen, dass wir uns ein Konzept oder eine Idee vorher absegnen lassen können, bevor wir mit der Entwicklung starten.

Visuelle Elemente in Dialoge integrieren

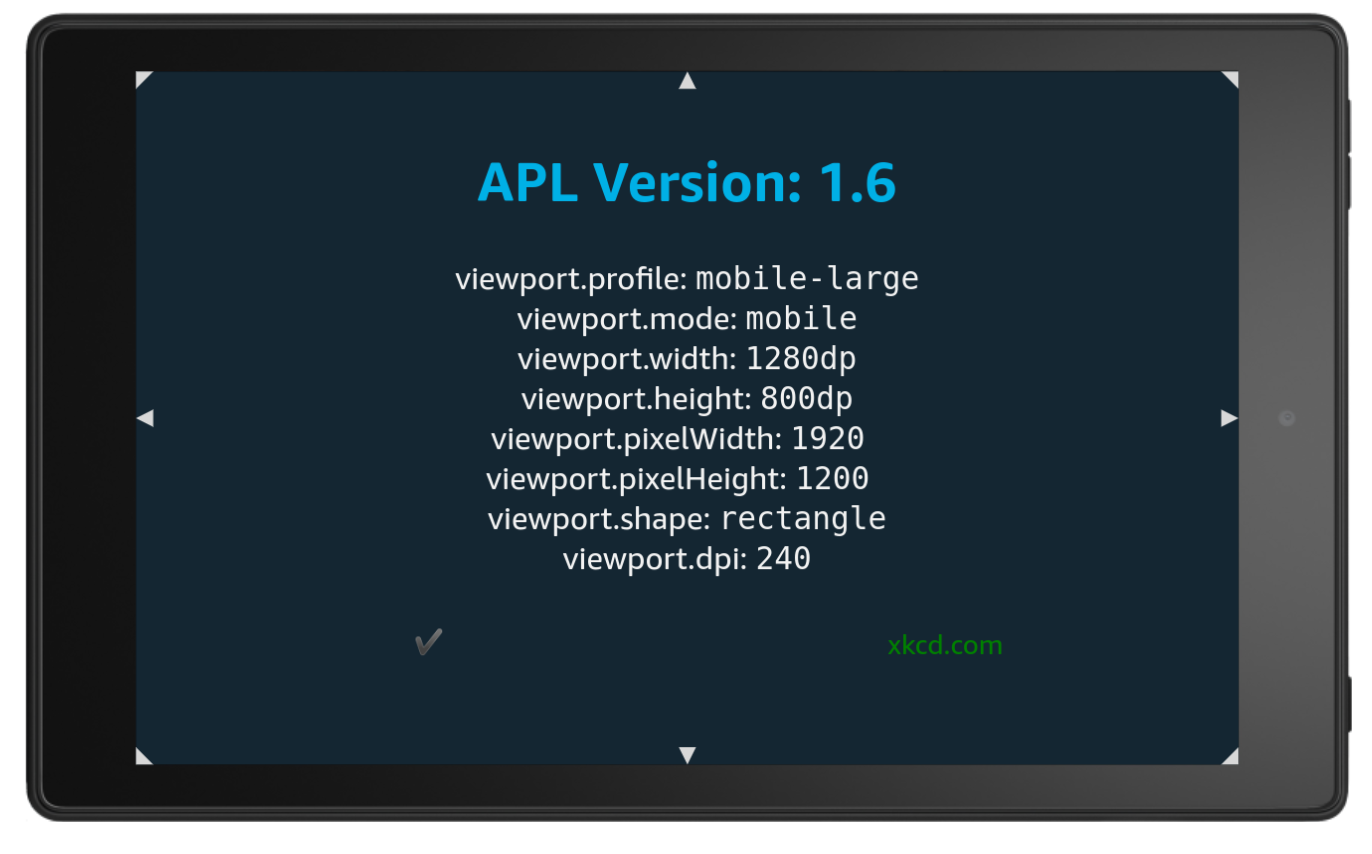

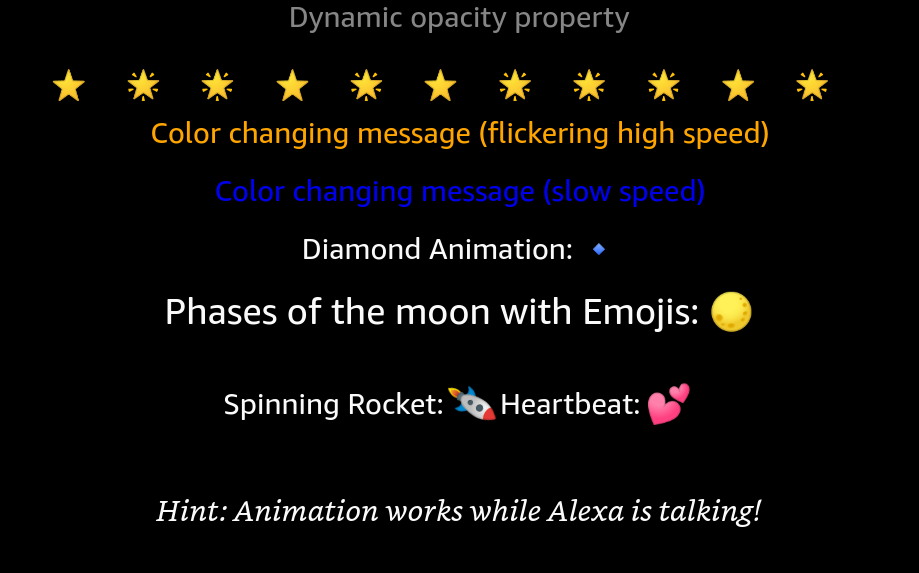

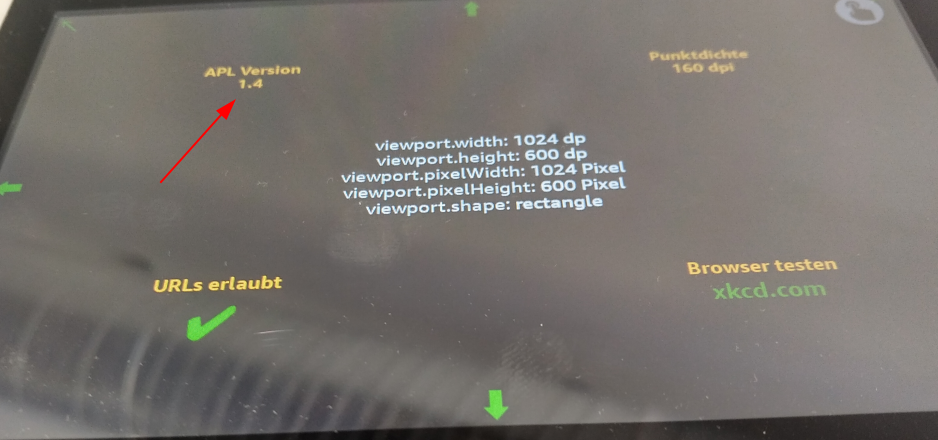

Ein Thema, das mir als Entwickler besonders am Herzen liegt, ist der Umgang mit der Alexa Presentation Language (APL) unter dem neuen Alexa+-Modell. In der Vergangenheit war APL ein mächtiges Werkzeug, um visuelle Erlebnisse auf Echo Show-Geräten individuell zu gestalten – von dynamischen Layouts bis hin zu Animationen und Touch-Interaktionen. Viele meiner Skills setzen APL aktiv ein.

Mit dem Aufkommen von Alexa+ wird sich die Rolle von APL aber verändern. Emerson machte deutlich: In der initialen Phase liegt der Fokus ganz klar auf Sprachinteraktionen. Das bedeutet konkret: APL wird zum Launch von Alexa+ nicht vollumfänglich unterstützt, die Diskussion zu diesem Thema scheint auch Amazon-intern noch nicht abgeschlossen zu sein.

Aktuell ist APL nach wie vor das zentrale Element für Skills mit starker UI-Komponente – etwa in den Bereichen E-Commerce, Bildung, Kochrezepte oder Multimedia. Ohne kontrollierbare visuelle Ausgabe besteht die Gefahr, dass Skills beliebig wirken oder gar an Interaktivität verlieren.

Ich hoffe, dass Amazon hier nachliefert – idealerweise mit einer hybriden Lösung, die vielleicht:

- promptbasiertes High-Level-Layout ermöglicht (“erstelle eine horizontale Galerie mit zehn Bildern“)

- aber auch optionalen Low-Level-Zugriff auf Komponenten bietet

- und APL-Inhalte besser mit semantischem Sprachkontext verknüpft

Ein klarer Fahrplan zur Zukunft von APL unter Alexa+ wäre wünschenswert. Vielleicht werden wir aber auch erleben, dass APL durch HTML-Derivate abgelöst wird.

Monetarisierung: Skills mit echten Geschäftsmodellen

Da In-Skill Purchasing (ISP) in Alexa+ (zumindest aktuell) keine zentrale Rolle spielt, funktioniert Monetarisierung künftig erst einmal über Konto-Verknüpfungen mit externen Services.

Fazit: Der nächste Schritt für Voice Developer

In dem Gespräch mit Emerson ist deutlich geworden: Alexa+ ist kein inkrementelles Update – es ist ein Paradigmenwechsel:

- KI statt starrer Regeln

- Prompts statt Intents

- Personalisierung statt Standarddialoge

Für Entwickler eröffnen sich neue Chancen – vorausgesetzt, man ist bereit, sich auf Prompt Engineering, API-Modularisierung und UX-zentrierte Konversationen einzulassen. Meine Erwartung ist, dass die Entwicklung von Skills in Zukunft aus technischer Perspektive mehr Spaß machen wird.

Nutzer- und Entwickleraktivierung bleibt entscheidend

Aber werden die neuen Skills auch ihre Nutzer finden? Skill discoverability war schon immer ein Problem. Wird das besser werden? Alexa+ kostet Geld oder benötigt ein Amazon-Prime-Abo. Zusätzlich setzen all die neuen Fähigkeiten von Alexa+ ein explizites Opt-in durch den Nutzer voraus.

Die Realität gerade im deutschen Markt erlebe ich zusätzlich so:

- Viele Nutzer sind zurückhaltend, wenn es um das Teilen persönlicher Daten oder das Aktivieren neuer KI-Funktionen geht.

- Datenschutzbedenken – gerade im deutschsprachigen Raum – wirken stark hemmend auf die Akzeptanz.

- Wenn Alexa+ nur dann sein volles Potenzial entfaltet, wenn Nutzer einer erweiterten Datennutzung zustimmen, entsteht ein Zielgruppenfilter, der die Reichweite vieler Skills begrenzen könnte.

- Sind genug Anwender dazu bereit, zusätzlich monatlich Geld auszugeben für eine Alexa+-Erfahrung?

Solange nicht klar ist, wie breit Alexa+ unter diesen Bedingungen überhaupt seine Nutzerbasis finden wird, bleibt die wirtschaftliche Tragfähigkeit vieler Use Cases ungewiss.

Und die Entwicklergemeinschaft? Als Alexa vor einigen Jahren in Deutschland startete, investierte Amazon massiv in die Community: Entwickler erhielten kostenlose Geräte, es gab Meetups mit warmen Buffet und regelmäßig stattfindende Hackathons. Einige der damals verteilten Geräte liegen bei mir noch originalverpackt im Regal.

Ob Amazon für Alexa+ ähnliche Maßnahmen plant, ist derzeit unklar. Eine gezielte Ansprache bestehender Nutzer und Entwickler wäre jedoch essenziell, um die neuen Möglichkeiten sichtbar zu machen – insbesondere für Besitzer älterer Echo-Geräte.

Ohne aktive Kommunikation und gezielte Unterstützung besteht die Gefahr, dass viele Nutzer von den erweiterten Fähigkeiten von Alexa+ nichts mitbekommen. Auch für Entwickler ist der Einstieg nur dann sinnvoll, wenn eine ausreichend große und interessierte Zielgruppe absehbar ist. Ohne diese Sichtbarkeit wird es schwer, Investitionen in neue Skills zu rechtfertigen.

Hinweis: Dieser Beitrag reflektiert meine persönlichen Eindrücke aus dem Gespräch mit Emerson Sklar und meiner Interpretation seiner Äußerungen. Es handelt sich nicht um offizielle Aussagen von Amazon.

Artikel über Private Prompts in golem.de

Gute Nachricht: auf golem.de ist ein Artikel über Private Prompts erschienen - leider hinter eine Paywall.

Demo Day in Berlin: Präsentation von Private Prompts

Beim Demo Day in Berlin durfte ich die Ergebnisse von Private Prompts präsentieren und im Rahmen einer Podiumsdiskussion über Datensicherheit diskutieren.

Die Resultate kann man sich auf der Homepage ansehen und wer es lieber technisch mag, der wird auf der Github-Projektseite fündig.

Gefreut habe ich mich darüber, dass am selben Tag auch ein Artikel im Wirtschaftsteil der Süddeutschen Zeitung über Private Prompts erschienen ist.

Private Prompts: erste BETA verfügbar

Private Prompts hat den MVP Status endgültig hinter sich gelassen und ist nun als BETA Version zur Evaluation verfügbar. Mit dieser Version werden nun alle drei Plattformen Windows, Linux und Mac unterstützt.

Was ist neu in der Beta-Version?

Die Beta-Version von “Private Prompts” bringt Neuerungen und Verbesserungen, die das Arbeiten mit dem Tool noch effizienter und sicherer machen. Hier ein Überblick über die Highlights:

Erweiterte Smart Matcher für den Schutz sensibler Daten

- Erkennung und Maskierung von Kreditkartennummern

- Erkennung und Maskierung von IBAN-Nummern

- Erkennung und Maskierung von IPv4-Adressen

- Erkennung und Maskierung von IPv6-Adressen

Suchfunktionalität

- Umfassende Suchfunktion im PromptManager: Suche mit Tag- und Plattform-Filtern.

- Verbesserte Filterlogik: Erhöhte Sichtbarkeit des Such-Buttons abhängig von gefilterten Prompts.

Allgemeine Verbesserungen der Benutzeroberfläche

- Verbesserter PromptManager: Klarere Layouts, Labels und Styling für Tags und Plattformen.

- Neues Reset-Button-Icon und Label für das Suchfeld: Verbesserte Übersicht und optimierter Workflow.

Plattform-Unterstützung

- macOS-Unterstützung: “Private Prompts” kann nun erstmals auf macOS gebaut und ausgeführt werden.

Refactoring und Stabilität

- Stabilitätsverbesserungen: Zahlreiche Fehler wurden behoben, was die Zuverlässigkeit der App steigert.

- Code Cleanup: Unbenutzte Komponenten wurden auskommentiert, und der Code wurde optimiert.

- Main-Prozess: Menüerstellung und IPC-Handler-Registrierung in

main.tswurden optimiert. - Projektstruktur: Der Wechsel zu einer Monorepo-Struktur ist abgeschlossen.

Tests und Sonstiges

- Unit-Tests: Smart Matcher wurden durch umfassende Unit-Tests robuster gemacht.

- Beta-Version: Artefaktnamen und Banner wurden aktualisiert, um den Beta-Status zu unterstreichen.

Entdecke die Beta-Version und teste die neuen Funktionen – mit deinem Feedback hilfst du mir dabei, Private Prompts noch besser zu machen.

Private Prompts: zweiter MVP verfügbar

Es geht weiter: Die zweite Version eines MVP von Private Prompts steht für Download und Evaluation bereit!

Was ist neu?

In diesem Release lag der Fokus auf der Umstrukturierung des Quellcode-Repositories. Wir nähern uns einer sauberen und effizienten Monorepo-Struktur. Die wichtigsten Verbesserungen für dich:

Verbesserte Stabilität

Zahlreiche Fehler wurden behoben, was die Benutzererfahrung reibungsloser und zuverlässiger macht.Schnellere Performance

Die Verwaltung großer Regelsets und Prompts erfolgt nun spürbar schneller. Selbst auf älterer Hardware äuft Private Promptas nun flüssig.Neue Features und Icons

Private Prompts sieht schöner aus.Benutzerdefiniertes Menü hinzugefügt

Dies ist erst der Anfang. Eine Vision ist es, “Private Prompts” irgendweann vollständig ohne Maus bedienbar zu machen.Vollständiger “Send to AI”-Rundlauf

Der optional einsetzbare Button “Send To AI” ermöglicht nun einen nahtlosen Ablauf und bietet einen vollständig integrierten Prozess.Verbesserte responsive Oberfläche

Die Benutzeroberfläche passt sich effektiver an verschiedene Geräte und Bildschirmlayouts an.Reduzierte Dateigröße

Die Binärdateien sind jetzt über 100 MB kleiner und bieten dennoch eine bessere Leistung als bei MVP Version 1.

Ich freue mich über Rückmeldung 😊

Quo Vadis Alexa?

Der Oktober ist vorbei: Amazon hatte groß angekündigt, Alexa mit Hilfe von Large Language Models (LLMs) auf ein neues Level zu heben. Doch statt eines bahnbrechenden Updates erleben wir erneut Verzögerungen auf unbestimmte Zeit und Unklarheiten sowie schlechte Nachrichten, die wenig vielversprechend klingen:

Berichten zufolge plant Amazon, die erweiterte Version von Alexa als kostenpflichtiges Abonnement anzubieten, mit monatlichen Gebühren zwischen 5 und 10 US-Dollar. Angesichts der bisherigen Nutzung von Alexa für einfache Aufgaben wie Wetterabfragen oder Timer stellt sich die Frage, ob Nutzer bereit sind, für zusätzliche Funktionen zu zahlen. Ich kann mir höchstens vorstellen, dass so ein Schritt erfolgreich sein könnte, wenn das Angebot in bestehende Dienste wie Amazon Prime integriert wird.

Technische Herausforderungen

Die Integration von LLMs in Alexa bringt erhebliche technische Hürden mit sich. Probleme wie Halluzinationen – also falsche oder irreführende Antworten – sowie Latenzzeiten beeinträchtigen die Zuverlässigkeit des Assistenten. Statt diese Herausforderungen offen zu kommunizieren, scheint Amazon zu versuchen, ein perfektes Produkt zu präsentieren, was jedoch kaum realistisch ist. Eine transparente Kommunikation über die Grenzen der Technologie wäre hier aus meiner Sicht der bessere Weg. Auch andere LLM-Anbieter machen deutlich: “KI kann Fehler machen“.

Latenzzeiten waren schon immer ein Schwachpunkt von Alexa. Die Nutzer sind also Kummer gewohnt. Um hier Verbesserungen zu erzielen, müsste Amazon in leistungsfähigere Backend-Hardware investieren. Doch bisher bleibt es bei Ankündigungen ohne konkrete Maßnahmen. Amazon hat in Werbevideos viel versprochen und kann diese Erwartungen nun nicht erfüllen.

Meine Einschätzung

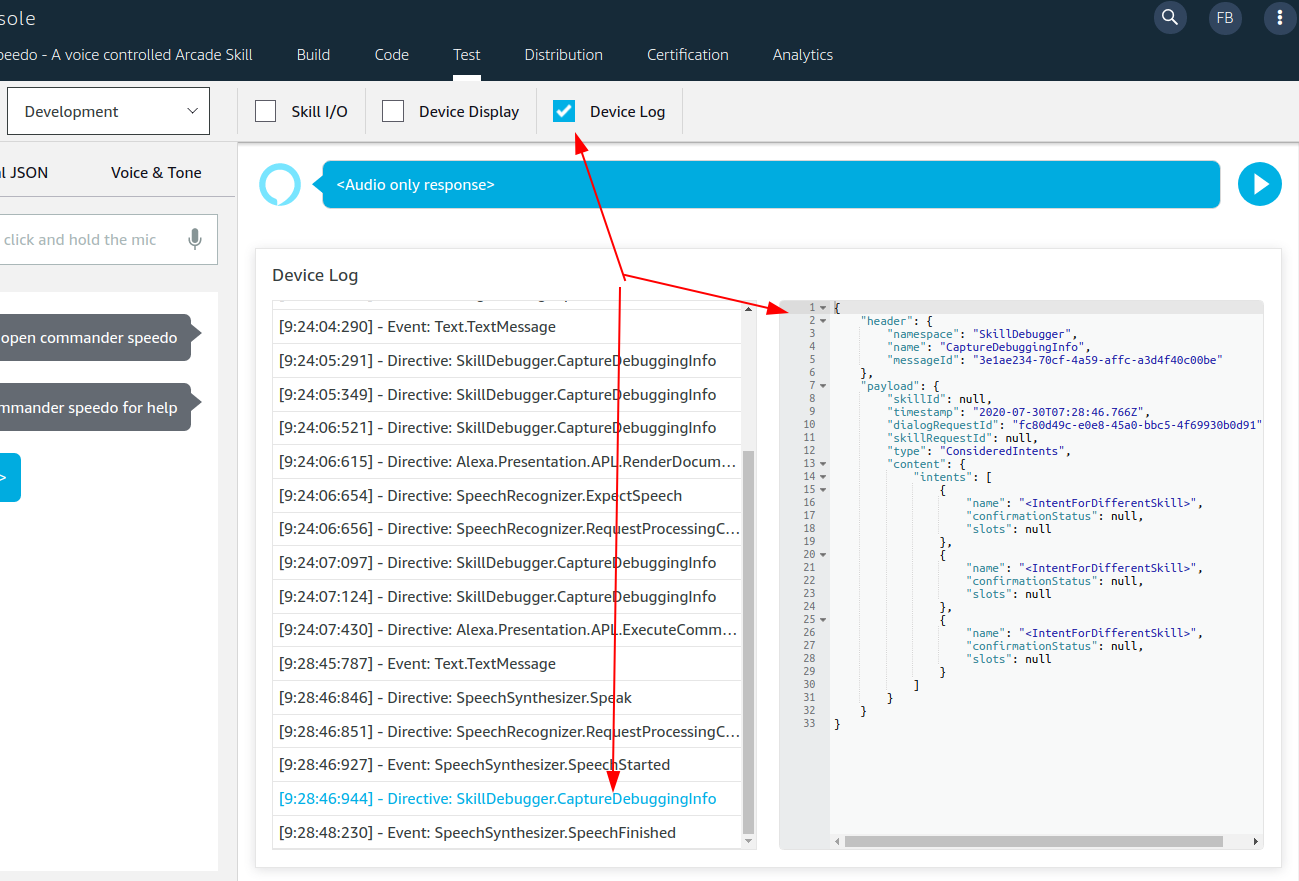

Grundsätzlich halte ich den LLM-Ansatz aber für richtig. Ich habe für eigene Zwecke selbst einen Alexa-Skill-Prototyp entwickelt, der mittels APL-Unterstützung die Interaktion mit ChatGPT ermöglicht und den Chat visuell darstellt. Diese private Nutzung zeigt mir, dass eine solche Integration grundsätzlich funktioniert und echten Mehrwert bieten kann.

Trotzdem sehe ich Amazons Ansatz kritisch: Ein unausgereiftes Produkt, das dem Kunden zuviel verspricht und dann noch Kosten aufbürdet, könnte dem Vertrauen in Alexa langfristig und nachhaltig schaden.

Amazon hat bei diesem Vorhaben nur einen Versuch – und dieser muss sitzen.

Homepage www.privateprompts.org ist online!

Ich freue mich, dir meine neue Webseite www.privateprompts.org vorstellen zu dürfen!

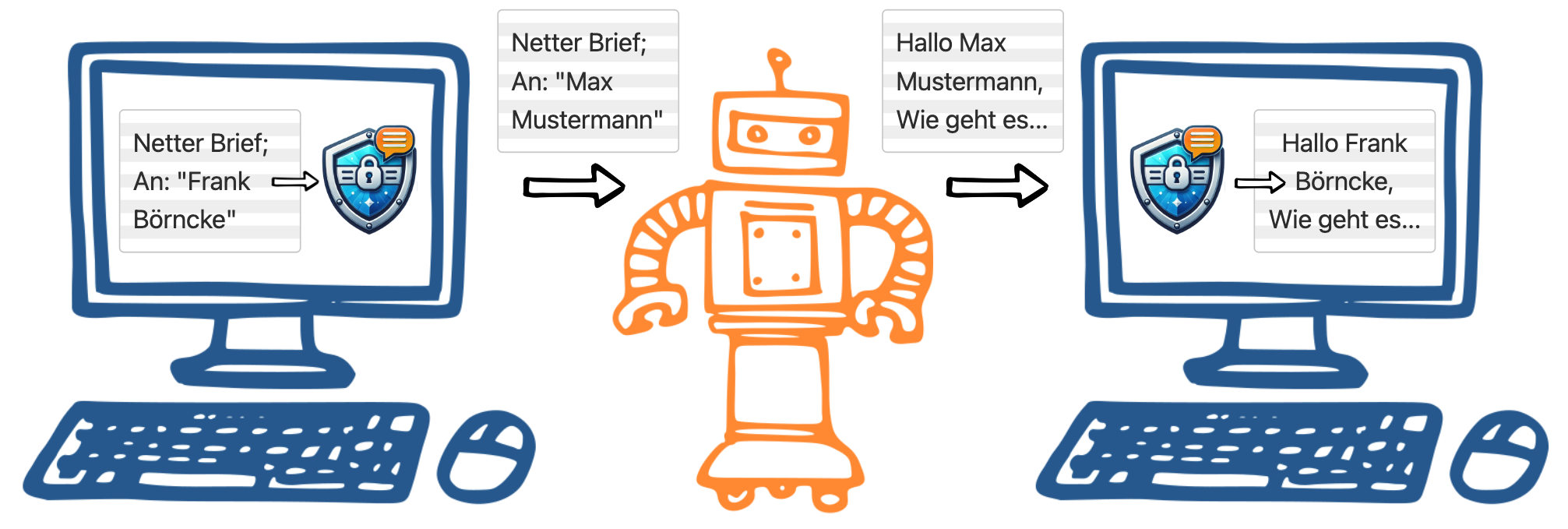

Private Prompts ist ein datenschutzfreundliches Tool, das es dir ermöglicht, sensible Informationen in Texten durch Platzhalter zu ersetzen, bevor deine Anfragen sicher in Webdiensten verarbeitet werden. Nach der Verarbeitung werden die pseudonymisierten Daten lokal wieder in ihren ursprünglichen Kontext zurückübersetzt, wodurch deine Privatsphäre geschützt bleibt.

Mein Ziel ist es, die Nutzung von KI-gestützten Texttools sicherer zu gestalten, ohne auf deren Vorteile verzichten zu müssen.

Besuche www.privateprompts.org, um mehr über die Funktionen von Private Prompts zu erfahren und wie es dir helfen kann, deine Daten zu schützen.

Private Prompts: erster MVP ist live

Endlich: Eine erste Version des Minimum Viable Product (MVP) von Private Prompts steht nun zur Evaluation bereit!

Wer sich für das Projekt interessiert, ist eingeladen, den MVP auszuprobieren. Ich freue mich sehr auf und über Feedback, um das Tool weiter zu verbessern.

Because you own your data: “Private Prompts”

Als mittlerweile fast täglicher Nutzer von KI-Anwendungen beschäftige ich mich seit einiger Zeit intensiv mit dem Thema, wie wir in einer digitalen Welt AI-Tools nutzen und dabei trotzdem die Kontrolle über unsere eigenen Daten behalten können. So ist mein Projekt Private Prompts entstanden, das aktuell vom Prototype Fund gefördert wird. Private Prompts wird eine einfache Möglichkeit schaffen, KI-gestützte Tools zu nutzen, ohne dabei persönliche Daten preiszugeben.

Worum geht es genau?

Jedes Mal, wenn wir sensible Informationen – sei es für Übersetzungen, Support oder Textbearbeitung – in Online-Tools hochladen, riskieren wir, dass diese auf Servern gespeichert, weiterverarbeitet oder im schlimmsten Fall durch Datenpannen für Unbefugte zugänglich werden.

Gerade im beruflichen Umfeld kann es heikel sein, wenn vertrauliche Daten wie Kundendetails oder Information über Projekte den eigenen Rechner verlassen. Mit Private Prompts möchte ich sicherstellen, dass diese Daten geschützt bleiben, indem ich eine Methode nutze, die persönliche Informationen im Bearbeitungsprozess unkenntlich macht und nach der Verarbeitung wiederherstellt – und das alles lokal auf dem eigenen Gerät. So bleiben persönliche Daten unter der eigenen Kontrolle – und KI-Anwendungen lassen sich sicher nutzen.

Eigene Daten schützen

Die Idee ist, dass Nutzer ihre Arbeitsschritte wie gewohnt erledigen können, ohne sich Gedanken darüber zu machen, wo die Daten zwischengelagert werden. Das System sorgt im Hintergrund dafür, dass keine sensiblen Informationen nach außen gelangen. So bleibt alles in den eigenen Händen, ohne dass man auf die Effizienz von KI verzichten muss. Welche Daten geschützt werden, definiert der Nutzer von Private Prompts selbst – was privat und schützenswert ist, ist schließlich für jeden individuell.

Veröffentlichungen

Private Prompts wird als Open-Source-Lösung zugänglich sein. Das schafft Vertrauen und ermöglicht es Nutzern, eigene Ideen einzubringen. Gerade jetzt in der Entwicklungsphase freue ich mich über Feedback und Anregungen von Gleichgesinnten – sei es, weil sie datenschutzfreundliche KI-Lösungen unterstützen möchten oder einfach neugierig auf das Projekt sind.

Echo Expert: KI-Assistent für Alexa Skill Entwickler

Bei Fragen rund um Alexa Skill Entwicklung inklusive APL (Alexa Presentation Language) und ISP (In-skill purchasing) hilft nun der KI-Assistent Echo Expert. Der Assistent unterstützt nicht nur mit Erklärungen und Code-Beispielen sondern bietet auch Code Review an, wenn es mal klemmt oder man als Entwickler einfach nur eine zweite Meinung wünscht.

Wer Echo Expert ausprobieren möchte, kann auf diesen Link klicken.

Hinweis: Zur Verwendung ist ein Zugang zu ChatGPT Plus erforderlich.

Darwin: Mein erster GPT Assistent für ChatGPT

Vergangene Woche hat OpenAI mit GPT Builder einen neuen Weg vorgestellt, eigene KI-Assistenten für ChatGPT zu erstellen.

Mit Darwin habe ich eine erste Version eines solchen Assistenten gebaut und veröffentlicht. Darwin ist für wissenschaftliche Themen rund um Genetik, Evolution und Biologie optimiert und verbindet aktuelle Forschung mit verständlichen Erklärungen.

GPT-Assistenten wie Darwin sind Variationen von ChatGPT, angepasst für spezifische Aufgaben oder Wissensbereiche. Sie nutzen AI-Modelle, um Nutzerfragen zu verstehen und darauf zu antworten, und können für spezielle Zwecke oder Fachgebiete maßgeschneidert sein.

Wer Darwin ausprobieren möchte, kann auf diesen Link klicken.

Hinweis: Zur Verwendung ist ein Zugang zu ChatGPT Plus erforderlich.

Olympus: Wie Amazon mit LLMs und Alexa den Markt erobern will

Da tut sich was: Amazon investiert mehrere Millionen in die Entwicklung eines neuen, ehrgeizigen Large Language Models (LLM), das den Codenamen “Olympus“ trägt. Ziel des Projekts ist es, mit führenden Modellen von OpenAI und Alphabet zu konkurrieren. Olympus soll eines der größten trainierten Modelle sein und verfügt über zwei Billionen Parameter, was es größer als das aktuelle GPT-4 Modell von OpenAI machen würde, wie TECHZINE und The Tech Portal berichten.

Das Projekt unterstreicht Amazons Investment im Bereich KI und zielt darauf ab, ein neues Gesprächs-KI-Tool zu entwickeln, das mit ChatGPT und Bard konkurrieren könnte. Quellen innerhalb des Unternehmens berichten, dass sowohl Ressourcen als auch Personal aus den Alexa KI- und Wissenschaftsteams zugeteilt wurden, um die Entwicklung von Olympus zu leiten (siehe Artikel auf ITPro.).

Darüber hinaus könnte das neue LLM von Amazon Funktionen in seinem Online-Handelsgeschäft, im Alexa-Sprachassistenten auf Geräten wie dem Echo und in seiner Amazon Web Services-Sparte antreiben (The Information).

Alle diese Informationen deuten darauf hin, dass Amazon seine Präsenz und Kapazitäten im Bereich der KI weiter ausbauen möchte. Alexa ist die logische Plattform, um damit viele Menschen zu erreichen, denn die Plattform ist bereits in vielen Haushalten präsent.

Alexa und Generative KI: Die Zukunft der Sprachinteraktion

Amazon hat Neuerungen rund um seine Sprachassistentin Alexa, vorgestellt. Bei der Vorstellung neuer Geräte wurde auch eine Vision präsentiert, mit Alexa zu interagieren, nämlich die Integration von einem Large Language Model (LLM). Einzelheiten zum verwendeten LL-Modell sind noch nicht bekannt. Dieser neue konzeptionelle Ansatz könnte die Art und Weise, wie wir mit Alexa interagieren, grundlegend verändern.

Amazon ermöglicht damit eine natürlichere Interaktion mit Alexa, bei der im Dialog das Aktivierungswort “Alexa“ entfällt. Das Gespräch beginnt mit “Alexa, let’s chat“ und endet mit “Exit“. Details zur Aktivierung (muss ich immer auf den blauen Balken/Ring warten, oder ist der fortdauernd aktiviert?) und möglichen Zeitbeschränkungen (gibt es weiter ein 8 Sekunden Zeitfenster?) bleiben aber noch unklar. In den beiden Videos in diesem Artikel kann man einen ersten Eindruck davon gewinnen, wie sich Dialoge anfühlen können, die nach dem neuen Modell umgesetzt sind.

Für Alexa-Entwickler und Agenturen eröffnen sich mit diesen Ankündigungen neue Perspektiven. Es wird möglich sein, individuelle Erweiterungen (werden die dann noch Skills heissen?) für Alexa zu entwickeln und eigene APIs und Backends zu integrieren. Dies stellt einen innovativen Ansatz für die Erstellung von Alexa-Skills dar, der aber leider vorerst nur in den USA verfügbar sein wird. Werden wir ISP in diesem Modell nutzen können, um Erweiterungen zu monetarisieren? Auch das wissen wir noch nicht.

Weitere Informationen zur Integration und den Entwicklungsaspekten finden sich in diesem Entwicklerbeitrag.

Die Zukunft der Sprachinteraktion mit Alexa wird sich mit diesem Schritt verändern. Mit der Integration von generativer KI und erweiterten Entwicklungsmöglichkeiten ergeben sich neue Chancen auch für Entwickler von Alexa Skills.

Alexa Skill “Kurznachricht” ist live

Mit meinem erfolgreichen Alexa Skill “MemoMail“ gab es leider mehr und mehr Probleme, die sich auch in den Bewertungen spiegeln. Was ist passiert? Der Invocation Name “Memo Mail” wurde sowohl in der deutschen wie auch in der englischen Fassung des Skill früher super erkannt, heute funktioniert es leider nur mit veränderter Betonung und oft braucht es dazu mehrere Versuche. Das macht den eigentlich sehr nützlichen Skill unbrauchbar. Irgendwas hat Amazon an der Spracherkennung geändert.

Leider erlaubt es Amazon nicht, den Namen von einem Skill nachträglich zu ändern. Deshalb führte der Weg zu einer besseren Version nur über eine komplette Neuinstallation unter einem anderen Skill-Namen. Dies habe ich zum Anlass genommen, den Skill komplett zu überarbeiten. In der deutschen Version ist er nun seit gestern unter dem Namen “Kurznachricht“ verfügbar. Auch APL wird bei Geräten mit Bildschirm unterstützt.

Worum geht es bei dem Skill? Im hektischen Alltag ist eine gut organisierte To-Do-Liste unverzichtbar, um den Überblick über Aufgaben und Erinnerungen zu behalten. Mit dem Alexa Skill “Kurznachricht” wird diese Organisation auf eine originelle Weise vereinfacht. Der Skill verwandelt deine gesprochenen Nachrichten in E-Mail-Betreffzeilen und schickt sie direkt an deine mit dem Alexa-Account verknüpfte E-Mail-Adresse.

Auch ein kompakter Aufruf wird unterstützt: “Alexa, öffne Kurznachricht und schicke mir den Text: Kuchen backen nicht vergessen.‘“ Schon steht der Eintrag in der E-Mail-Inbox – eine zeitsparende Lösung! Viele Formulierungen werden erkannt und unterstützt. Hier sind einige Beispiele:

- “Alexa, öffne Kurznachricht und schicke mir den Text Kuchen backen nicht vergessen.“

- “Alexa, öffne Kurznachricht und erinnere mich an: Urlaubsbilder an Oma senden.“

- “Alexa, öffne Kurznachricht und sende mir: Ideen für den Geburtstag von Tom: Wanderschuhe, Konzerttickets.“

- “Alexa, öffne Kurznachricht und texte mir: Steuererklärung bis Ende des Monats abgeben.“

- “Alexa, öffne Kurznachricht und sende mir den Text: Morgen um 10 Uhr Zahnarzttermin.“

Tipp: Je prägnanter der gesprochene Text, desto genauer kann Alexa ihn erfassen und in eine E-Mail umsetzen. Beachte jedoch, dass die Textlänge aus technischen Gründen begrenzt ist, daher ist es ratsam, die Kurznachrichten kurz und präzise zu halten.

Tipp: Der Betreff der E-Mail enthält außerdem das Symbol ‘📎’ und den Tag [Kurznachricht]. Das erleichtert bei Bedarf das Erstellen von automatischen Filterregeln.

Neugierig geworden? Einfach mal ausprobieren: 🇩🇪 https://www.amazon.de/gp/product/B0CCSJHHX7 (de-DE)

Interview: Zu Gast im “Public Interest Podcast”

Der “Der Public Interest Podcast - mit Technologien für eine bessere Welt” hat mich eingeladen zu einem Gespräch zu dem Thema “Wie profitieren Freiberufler*innen von FOSS-Entwicklung?”. Daraus ist eine interessante Podcast-Folge geworden.

Die Gastgeber schreiben dazu selber: “Die Entwicklung von Open-Source-Software kann eine große Bereicherung darstellen, auch wenn man eigentlich freiberuflich geschlossenen Code schreibt. Doch wie bringt man closed und open source unter einen Hut? Und wie profitiert die eigene Arbeit vom Engagement in der FOSS-Community?

Wir haben mit Frank Börncke gesprochen. Frank ist freiberuflicher Softwareentwickler und wurde mit seinem Projekt Voice-QL vom Prototype Fund gefördert. Mit ihm haben wir uns darüber unterhalten, wie seine Erwerbsarbeit von seiner Erfahrung bei der FOSS-Entwicklung profitiert und welchen Nutzen er ganz persönlich aus der Auseinandersetzung mit der FOSS-Community zieht.“

Mehr Informationen gibt es auf meiner Podcast-Seite mit zusätzlichen Informationen und Transkriptionen.

Neustart bei “R2-D2” - Irgendwie auch eine KI

Irgendwie ist “R2-D2“ Alexa Skill ja auch eine künstliche Intelligenz. Kürzlich hat er ein Update erhalten: damit verfügt er jetzt zusätzlich über ein neues Icon und unterstützt endlich auch APL (Alexa Presentation Language). Dadurch wird die Nutzung des Sprachassistenten noch ansprechender als zuvor.

Mit dem neuen Icon wird der R2-D2 Skill visuell ansprechender und einprägsamer, während APL Support dafür sorgt, dass Benutzer auf jedem kompatiblen Gerät mit mehr Spaß interagieren können.

Im Skill Store gibt es “R2D2 - Ask me Anything!“ hier:

- 🇩🇪 https://www.amazon.de/gp/product/B06XYQHPM9 (de-DE)

- 🇺🇸 https://www.amazon.com/gp/product/B06XYQHPM9 (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B06XYQHPM9 (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B06XYQHPM9 (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B06XYQHPM9 (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B06XYQHPM9 (en-AU)

Alexa Skill “Schlauberger” fühlt sich an wie ChatGPT mit Voice

Der Schlauberger-Skill ist eine praktische Anwendung, die schnelle und unkomplizierte Antworten auf Fragen aus verschiedenen Themengebieten wie Wissenschaft, Geschichte, Technologie, Musik und Sport liefert. Der Schlauberger ist der ideale Begleiter für Nutzer, die sich für bestimmte Themen interessieren und Antworten auf ihre Fragen suchen. Die Anwendung bietet leicht verständliche Erklärungen zu Fachbegriffen und liefert Informationen über Geographie, Kultur, Sehenswürdigkeiten und Stadtgeschichte.

Durch die Integration der KI-Schnittstelle von OpenAI eröffnen sich für Nutzer des Schlauberger-Skills zahlreiche Vorteile und Möglichkeiten. Die Technologie ermöglicht dem Skill, komplexe Themen verständlich zu erklären und schwierige Fragen schnell und zuverlässig zu beantworten. Nutzer profitieren von schnellen und präzisen Antworten auf ihre Fragen sowie leicht verständlichen Erklärungen zu komplexen Themen.

Der Skill kann Fachbegriffe und komplizierte Zusammenhänge in verständliche Sprache übersetzen und so das Verständnis für verschiedene Themengebiete erleichtern. Durch die Verbindung mit der KI-Schnittstelle von OpenAI eröffnen sich zudem neue Möglichkeiten, das Wissen auf eine neue Art und Weise zu erweitern.

Zusammenfassend bietet die Integration der KI-Schnittstelle von OpenAI Nutzern einen echten Mehrwert, indem sie ihr Wissen schnell, unkompliziert und auf eine leicht verständliche Art und Weise erweitern können.

Skill starten:

“Alexa starte Schlauberger“

Skill starten mit einer Frage:

“Alexa frage Schlauberger bitte nach dem Unterschied zwischen Volt und Ampere“

QuickLink

Im Skill Store

🇩🇪 https://www.amazon.de/dp/B0C2VNVGLZ (de-DE)

Update beim Alexa Skill “Zeiterfassung”

Die nächste Version vom Alexa Skill Zeiterfassung ist live.

Der aktualisierte Alexa Skill “Zeiterfassung” von Lexware erleichtert die Erfassung und Verwaltung von Arbeitszeiten für alle, die im Home-Office arbeiten. Durch einfache Sprachbefehle kann man die Arbeitszeit starten, stoppen oder pausieren. Der Skill bietet auch Konzentrationsmusik und sendet ein Protokoll der erfassten Arbeitszeit per E-Mail zu. Der Skill verfügt nun über viele direkte One-Shot-Launch-Phrasen, mit denen man noch produktiver arbeiten kann.

Es gibt viele nützliche Use-Cases für den Skill, zum Beispiel kann man durch die direkten One-Shot-Launch-Phrasen schnell zwischen verschiedenen Projekten wechseln und deren Zeiten separat erfassen. Auch ist es möglich, per Sprachbefehl eine Pause, Mittagspause oder Kaffeepause zu machen. Zudem kann man jederzeit den aktuellen Status abfragen und ein Protokoll per Sprachbefehl anfordern.

Eine weitere nützliche Funktion ist die Konzentrationsmusik, die man per Sprachbefehl aktivieren kann, um sich besser zu konzentrieren. Außerdem kann man mit dem Skill alle Benutzerdaten auf einmal löschen.

Insgesamt ist der Alexa Skill “Zeiterfassung” eine einfache und praktische Lösung für alle, die im Home-Office arbeiten und ihre Arbeitszeit effektiv und bequem verwalten möchten. Mit den neuen Funktionen und direkten One-Shot-Launch-Phrasen wird die Nutzung des Skills noch schneller und effizienter. Hier einige Beispiele, was nun zusätzlich möglich ist:

“Alexa, öffne Zeiterfassung“

“Alexa, öffne Zeiterfassung und starte Projekt {nummer}“

“Alexa, öffne Zeiterfassung und starte die Uhr“

“Alexa, öffne Zeiterfassung und mache eine Pause / Mittagspause / Kaffeepause“

“Alexa, öffne Zeiterfassung und pausiere die Uhr“

“Alexa, öffne Zeiterfassung und arbeite weiter“

“Alexa, öffne Zeiterfassung und mache Feierabend“

“Alexa, öffne Zeiterfassung und beende die Uhr“

“Alexa, öffne Zeiterfassung und schicke mir ein Protokoll“

“Alexa, frage Zeiterfassung nach einem Protokoll“

“Alexa, öffne Zeiterfassung und spiele Musik / Konzentrationsmusik / Deep Work Musik“

“Alexa, frage Zeiterfassung nach Musik / Konzentrationsmusik / Deep Work Musik“

“Alexa, öffne Zeiterfassung und lösche alle Benutzerdaten“

“Alexa, frage Zeiterfassung nach dem aktuellen Status“

Die Beispiele zeigen, dass nun auch zwischen mehreren Projekten unterschieden werden kann, deren Zeiten dann separat erfasst werden. Dazu kann man den Projekten eine Nummer geben. Auch die Auswertung im Report per E-Mail bieten in der Excel-Version separate Arbeitsblätter pro Projekt an.

Aufruf in Deutschland

"Alexa, starte Zeiterfassung"Im Skill Store:

🇩🇪 https://www.amazon.de/gp/product/B0BHD9KVQJ (de-DE)

Oder einfach mit dem Quick Link.

Prototype Fund: Video zum Demo Day in Berlin

Zum Demo Day in Berlin - die Abschlussveranstaltung für Runde 12 vom Prototype Fund - gibt es nun auch ein Video, das die Stimmung der Veranstaltung sehr schön einfängt:

Der Prototype Fund, ein Förderprogramm des Bundesministeriums für Bildung und Forschung, unterstützt innovative Ideen aus den Bereichen Civic Tech, Data Literacy und Open Source. Am 28. Februar 2023 fand in Berlin der Demo Day der zwölften Förderperiode statt, auf dem die Teams ihre Projekte vorstellen konnten.

Das Video zur Abschlussveranstaltung zeigt nicht nur Auszüge von den Präsentationen der Teilnehmer, sondern auch die Atmosphäre und Begeisterung vor Ort. In der zwölften Runde des Prototype Fund wurden 21 Projekte gefördert. Die Teams hatten sechs Monate Zeit, ihre Projekte zu realisieren.

Die Abschlussveranstaltung des Prototype Fund ist eine einmalige Gelegenheit, die Ergebnisse der Förderung kennenzulernen und sich mit den Entwicklerinnen und Entwicklern auszutauschen. Wer sich für die Arbeit des Prototype Fund interessiert, kann sich auf der Website des Förderprogramms über die Teilnahmebedingungen und aktuell geförderte Projekte informieren.

Mit dem Video zur Abschlussveranstaltung der zwölften Runde des Prototype Fund bekommt man einen guten Eindruck davon, was das Förderprogramm leistet und welche spannenden Projekte gefördert werden.

Ganz besonders freut mich, dass ich in dem Video so viel Redezeit abbekommen habe 🙂

Vortrag beim Demo Day in Berlin

Letzte Woche war ich auf dem Demo Day in Berlin und hatte die Gelegenheit, über mein Projekt Voice-QL zu sprechen. Es war großartig, meine Ideen mit anderen Entwicklern und Technologie-Enthusiasten zu teilen und verschiedene Innovationen zu entdecken und zu bestaunen.

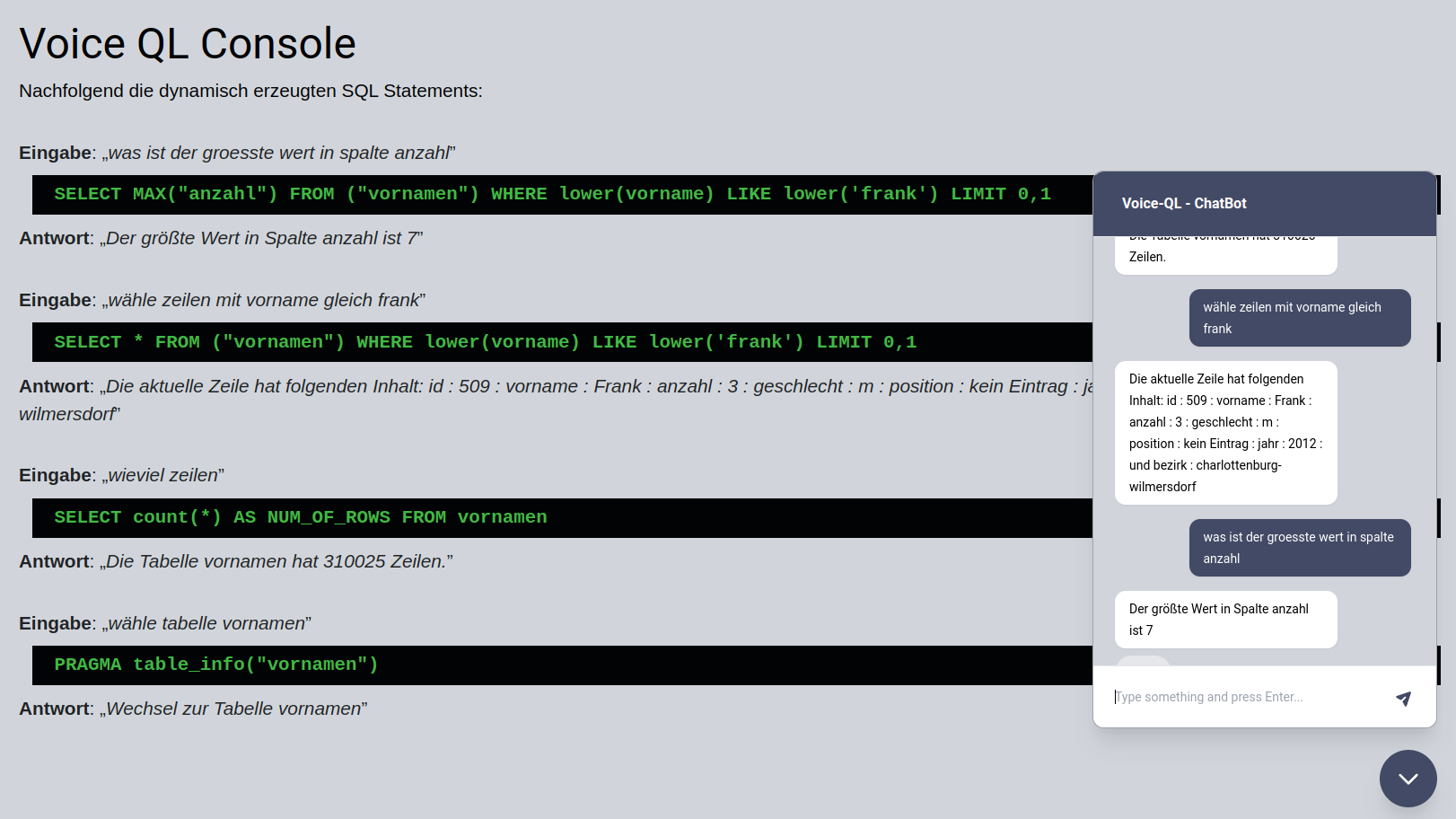

Voice-QL ist ein Projekt, das sich mit der Idee befasst, den Benutzer mit einer Tabelle sprechen zu lassen. Auf dem Demo Day konnte ich meine Vision von Voice-QL mit anderen teilen und erhielt viele positive Reaktionen auf das Projekt.

Der Demo Day war damit eine großartige Gelegenheit, um meine Arbeit zu präsentieren und Feedback von anderen zu erhalten. Hier noch einige Impressionen zu dem Tag:

Homepage für Voice-QL

Voice-QL ist ein neues Open-Source-Projekt, das die Entwicklung von Sprachanwendungen mit Hilfe des Frameworks Jovo deutlich vereinfachen soll. Endlich ist nun auch die Homepage für Voice-QL auf GitHub freigeschaltet.

Mit Hilfe von Voice-QL können Entwickler automatisch Anwendungen für verschiedene Ziel-Plattformen generieren lassen, die es möglich machen, dass ein Anwender mit einer Tabelle oder Datenbank sprechen und sich die Inhalte hands-free erschließen kann. Dies spart nicht nur Zeit, sondern verringert auch die Fehleranfälligkeit und macht die Entwicklung von Sprachanwendungen zugänglicher für Entwickler mit unterschiedlichen Erfahrungsgraden.

Interessierte Entwickler können Voice-QL auf GitHub herunterladen und in ihre eigenen Projekte integrieren. Die Nutzung ist kostenlos und es gibt keine Beschränkungen hinsichtlich der Anzahl der Anfragen oder der Anzahl der Benutzer.

Jovo Build Hook Magic Prototyper

Die Homepage für das Jovo Plugin Magic Prototyper ist nun freigeschaltet.

Mein Jovo V4 Community Hook Magic Prototyper ermöglicht es Entwicklern, Sprachprototypen schnell und einfach zu erstellen. Die Prototypen werden in einer zentralen JSON-Datei beschrieben und die Artefakte können auf verschiedene Sprachassistenten wie Alexa oder Google Assistant ausgeführt werden.

Das Projekt ist Open-Source und bietet Entwicklern die Möglichkeit, ihre eigenen Hooks hinzuzufügen oder zu modifizieren. Der Magic Prototyper ist für Entwickler konzipiert, die ihre Sprachprototypen schnell und effizient erstellen möchten und ist für die Integration in vorhandene Projekte geeignet.

Alexa Skill “Zeiterfassung”

Mit den Voiceagenten haben wir die nächste Version von dem Alexa Skill Zeiterfassung live gestellt.

Mit dem Alexa Skill “Zeiterfassung” kann jeder, der im Home-Office arbeitet, seine Arbeitszeiten einfach und bequem per Sprache erfassen und verwalten. Per Sprachbefehl kann der Benutzer die Messung der Arbeitszeit starten, stoppen oder pausieren.

Der Skill bietet außerdem Konzentrationsmusik an und sendet auf Wunsch ein Protokoll der erfassten Arbeitszeit per E-Mail zu.

Aufruf in Deutschland

"Alexa, starte Zeiterfassung"Im Skill Store:

🇩🇪 https://www.amazon.de/gp/product/B0BHD9KVQJ (de-DE)

Oder einfach mit dem Quick Link.

Und noch einmal: Jovo Community Member of the Month

Zum zweiten Mal bin ich zum Community Member of the Month bei Jovo ernannt worden und habe mir damit eine weitere Krone verdient 😀

Jovo Build Hook Magic Model

Die Homepage für Magic Model ist nun freigeschaltet.

Magic Model ist ein Hook für das Jovo V4 Framework, welches die Wartung von Sprachmodellen erleichtert. Durch die Unterstützung von Jexl-Ausdrücken und einer Ausdruckssprache innerhalb von Phrasen wird die Erstellung von Sprachmodellen erheblich vereinfacht. Darüber hinaus ermöglicht die Integration von Spintax eine kompaktere Notation der Sprachmodelldateien und automatisches Aufräumen der generierten Dateien.

Die Erstellung und Wartung von Sprachmodellen ist oft eine mühsame und langwierige Aufgabe, besonders wenn diese komplexer werden und wachsen. Die Erweiterung Magic Model hilft dabei, indem sie eine kompaktere Notation und Unterstützung für Spintax bietet.

Spintax ist eine Technologie, die es ermöglicht, aus einer einzigen Phrase eine Vielzahl von verschiedenen Ausdrucksweisen zu generieren, indem bestimmte Worte oder Phrasen in einer Klammergruppierung aufgelistet werden, von denen eine zufällig ausgewählt wird. Beispielsweise kann die Phrase “Ich {mag|liebe} Hunde” mit Spintax so erweitert werden, dass sie “Ich mag Hunde” oder “Ich liebe Hunde” ausgibt. Spintax wird verwendet, um schnell viele verschiedene Varianten einer Phrase zu generieren, ohne jede einzelne Phrase manuell zu schreiben.

Ein Anwendungsbeispiel dafür wäre die HelpIntent-Definition im Sprachmodell. Statt einer einzigen Phrase kann durch die Verwendung von Spintax eine Vielzahl von Phrasen erstellt werden, indem man Ausdrücke wie | oder [ ] verwendet. Eine Spintax Definition kann aussehen wie folgt:

HelpIntent: {

phrases: ["[ | [| would you ] please] [help|support|assist] [ | me [ | with this [| [|crazy|strange] [situation|problem] ] ]]"],

}Das Projekt ist Open-Source und bietet Entwicklern die Möglichkeit, ihre eigenen Hooks hinzuzufügen oder zu modifizieren. Magic Model ist für Entwickler konzipiert, die ihre Sprachprototypen schnell und effizient erstellen möchten und ist für die Integration in vorhandene Projekte geeignet.

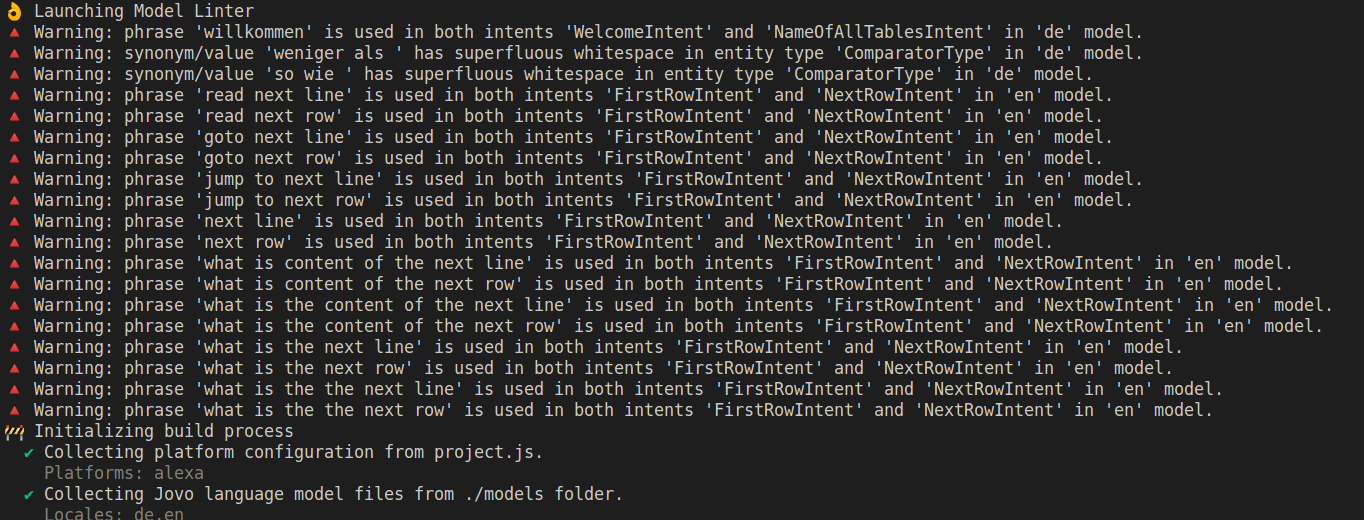

Jovo Hook Model Linter

Die Homepage für Model Linter ist nun freigeschaltet.

Mein Jovo V4 Community Hook Model Linter ermöglicht es Entwicklern, Sprachmodelle schon im Buildprozess zu validieren. “Model Linter” erleichtert und verbessert damit die Erstellung von Sprachmodellen.

Das Erstellen und Verwalten von Sprachmodell-Dateien kann eine Herausforderung sein, insbesondere wenn die Dateien größer werden und Veränderungen vorgenommen werden sollen. Dies kann unerwartete Seiteneffekte in einer Sprach-App auslösen. Das Model Linter ist eine Art “Linting” für Sprachmodelle und führt eine Analyse auf Codeebene durch, um offensichtliche und verdächtige Konstrukte im Sprachmodell aufzuspüren, noch bevor sie zur AUsführung kommen.

Durch das Hinzufügen von Model Linter in den Build-Prozess können die Sprachmodell-Dateien automatisch auf eine Reihe von Regeln hin überprüft werden. Die Philosophie ist es dabei, keine Build-Fehler zu verursachen, sondern aussagekräftige Warnungen auf der Konsole auszugeben, falls etwas auffällig ist. Dies erleichtert die Überprüfung von Sprachmodell-Dateien und verbessert deren Qualität.

Das Projekt ist Open-Source und bietet Entwicklern die Möglichkeit, ihre eigenen Hooks hinzuzufügen oder zu modifizieren. Der Model Linter ist für Entwickler konzipiert, die ihre Sprachprototypen schnell und effizient erstellen möchten.

Voice-QL

Es geht voran: Die Projektbeschreibung für mein gefördertes Projekt “Voice-QL“ ist jetzt online.

Worum geht es? Durch die Nutzung von Sprachbefehlen sollen Nutzer in der Lage sein, ihre Datenbankabfragen ohne umständliches Tippen von Suchanfragen durchzuführen. Die Technologie, die hinter “Voice-QL” steht, ermöglicht es, die Spracheingaben automatisch in Datenbankanfragen umzuwandeln und sie dann in Echtzeit zu verarbeiten. Die Ergebnisse werden vorgelesen oder - wie ein Prototyp zeigen wird - im Browser auf dem Bildschirm des Nutzers angezeigt.

Momentan befinden wir uns noch in der Entwicklungsphase, aber auf einem GitHub-Account von dem Projekt wird man bald den Stand der Dinge aktuell verfolgen können.

Zehn Empfehlungen für Sprach-Apps

Hier einige Empfehlungen zur Entwicklung von Sprachanwendungen aus einem Alexa Newsletter, die ich alle nur bestätigen kann:

- Do one thing really well

- Use a memorable invocation name and utterances

- Focus on intents rather than commands

- Simplify choices

- Pass the one-breath test

- Include a variety of responses

- Handle the unexpected gracefully

- Use analytics to make enhancements

- Provide contextual help

- Do beta testing

IHK-Magazin berichtet über die Voiceagenten

Lesetipp: Das aktuelle IHK-Magazin Wirtschaft (Ausgabe Juli-August 2022) berichtet mit einem Interview von Paulos Mesghina über die Voiceagenten und erwähnt dabei auch meine Mitarbeit bei Kundenprojekten:

Förderung durch den PrototypeFund

Diesmal hat es geklappt. Nach mehreren Anläufen freue ich mich sehr darüber, bei der 12. Runde vom PrototypFund als vom BMBF geförderter Teilnehmer mit dem Projekt “Voice-QL“ mit dabei sein zu können.

Wer noch nie davon gehört hat: Der Prototype Fund ist ein Förderprogramm des Bundesministeriums für Bildung und Forschung (BMBF), das von der Open Knowledge Foundation Deutschland betreut und ausgewertet wird. Einzelpersonen und kleine (interdisziplinäre) Teams können finanzielle und ideelle Unterstützung für die Erprobung von Ideen sowie die Entwicklung von Open-Source-Anwendungen in den Bereichen Civic Tech, Data Literacy, IT-Sicherheit und Software-Infrastruktur erhalten.

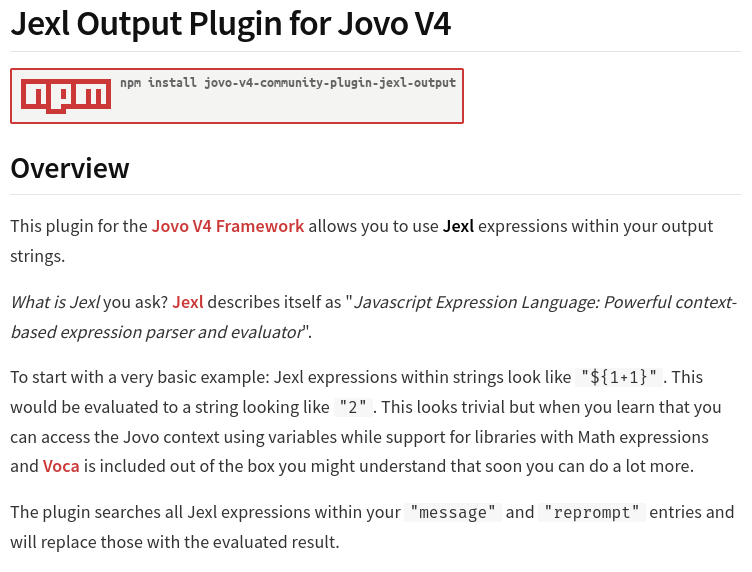

NPM Package: Jexl Expression Language Plugin für Jovo

Jexl ist eine JavaScript Expression Language, die leicht in eigene Anwendungen eingebettet werden kann. Mit meinem Jexl Plugin für Jovo können Jexl-Expressions nun auch in Alexa Skills oder Google Actions verwendet werden.

Den Quelltext gibt es auch auf github.

AI mit BLOOM - (M)eine Anleitung für Einsteiger

Die Welt der künstlichen Intelligenz (KI) ist für viele Menschen noch immer ein schwer zugängliches Terrain, das nur von Experten und Spezialisten betreten werden kann. Doch das ändert sich allmählich, und das liegt nicht zuletzt an neuen Entwicklungen wie dem System BLOOM. BLOOM ist ein AI-Modell, das auf der Transformer-Architektur basiert und von der Open-Source-Plattform Hugging Face bereitgestellt wird. Mit diesem System wird es für jeden theoretisch möglich, mit AI-gestützter Textgenerierung zu experimentieren – ohne dass dafür besondere Vorkenntnisse oder technisches Know-how erforderlich wären.

Wie es sich anfühlt, mit BLOOM und AI gestützter Textgenerierung zu experimentieren - und wo die Grenzen sind - darüber habe ich basierend auf meinen Erfahrungen mit GPT-3 einen Artikel auf LinkedIn veröffentlicht.

Der Artikel ist bewusst nicht so technisch gehalten und sollte es jedem Einsteiger ermöglichen, schnell mit eigenen Experimenten zu starten.

AI mit BLOOM - Wie man die API über Node.JS benutzt

Wenn Du BLOOM über eine API programmatisch aufrufen möchtest, bietet die Verwendung von Node.js viele Vorteile. Zum einen kannst Du dank der plattformübergreifenden Eigenschaften von JavaScript sicherstellen, dass Deine Anwendung auf allen Betriebssystemen einheitlich funktioniert. Zum anderen ermöglicht Node.js eine hohe Skalierbarkeit und eine effektive Handhabung von gleichzeitigen Anforderungen. Dies ist besonders für Anwendungen mit hohem Datenverkehr oder hoher Last unerlässlich.

Wer nun BLOOM nicht über eine Weboberfläche bedienen möchte, sondern lieber programmatisch auf eine API zugreift, für den habe ich die nötige Vorgehensweise Schritt für Schritt auf GitHub dokumentiert. Wenn Ihr der Anleitung folgt, habt Ihr zügig eine erste Lösung am Laufen:

A simple starter for AI with BLOOM using Node.js

“Zu Gast” im Podcast von “Between Two Beans”

In der Episode 23 vom Podcast “Between Two Beans” diskutieren William Rongholt und Kevin Evans über meine Arbeit, meine Alexa Skills und unsere gemeinsamen Erwartungen an die Alexa Live 2022:

Mehr Informationen gibt es auf meiner Podcast-Seite mit zusätzlichen Informationen und Transkriptionen.

Mein Wunschzettel zur Alexa Live 2022

Seit der Alexa Live 2021 ist bald ein Jahr vergangen. Damals habe ich vor der Veranstaltung einen Wunschzettel Alexa Live 2021 mit meinen Erwartungen veröffentlicht.

Was ist seitdem passiert, welche Wünsche haben sich erfüllt und welche sind neu dazu gekommen?

Dazu findet Ihr einen neuen Artikel “Alexa Live 2022 Wishlist” auf LinkedIn.

Jovo Community Member of the Month

Nun ist es raus: jetzt darf ich mich auch “Community Member of the Month“ für Jovo nennen 😀

NPM Package: Spintax Plugin für Jovo

Es gibt nichts, was man nicht noch besser machen kann. Deshalb habe ich für Jovo ein Spintax Plugin geschrieben und per NPM allgemein und frei verfügbar gemacht. Damit wird es leichter, für Alexa Skills und Google Actions Dialoge zu implementieren, die abwechslungsreich und damit natürlich klingen. Den Quelltext gibt es auch auf github.

Ganz offiziell: Jovo empfiehlt mein Master-Template “Pizza Party”

Die Webseite jovo.tech empfiehlt nun ganz offiziell meine Master-Template-Anwendung “Pizza Party“, die demonstriert, wie man das Projekt für eine Jovo-Sprachanwendung aufsetzen kann, die dann auf mehreren Plattformen wie Alexa und Google Assistant ausführbar ist.

Smarthome Assistant schreibt über “Mein Dashboard”

Das Online Magazin “Smarthome Assistant“ hat einen schönen Artikel über “Mein Dashboard” geschrieben und dabei über eine “Widget Alternative für Echo Show“ gesprochen:

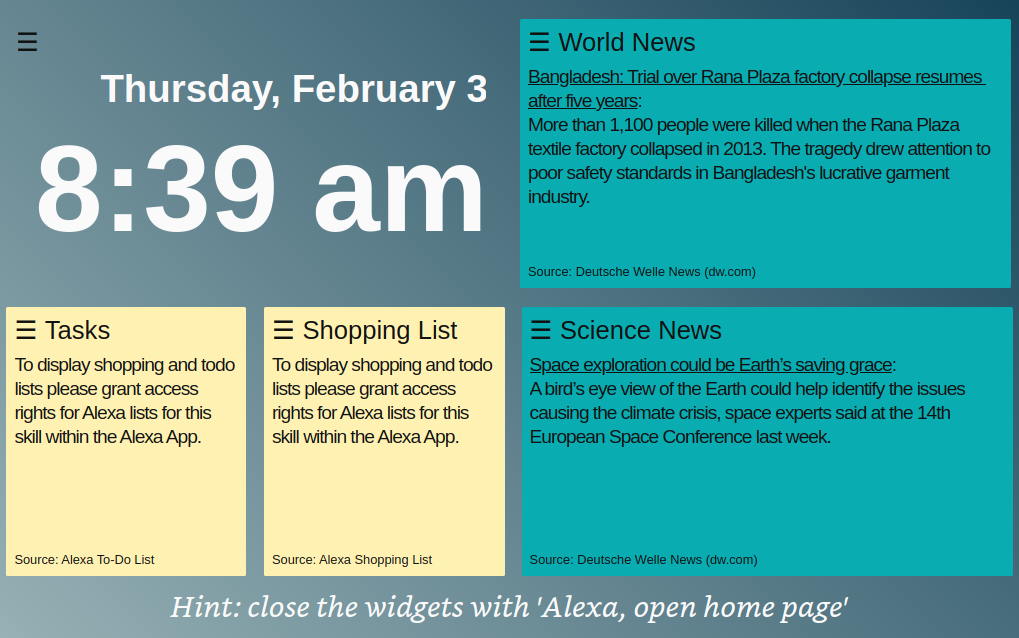

“Mein Dashboard” für Amazon Fire Tablets

Wer noch ein Fire 10” Tablet mit Alexa-Unterstützung in der Schublade hat, der kann nun auch auf diesem den Alexa Skill “Mein Dashboard” starten.

Endlich wird auf diesem Gerät auch der Hochkantmodus unterstützt:

In der dreizeiligen Ansicht wird in der Mitte ein Livestream abgespielt (Radio oder TV), während oben und unten nützliche Informationen angezeigt werden.

Hängt Euch das Tablet an die Wand und ihr habt einen - zugegeben einfachen - Ersatz für einen Echo Show 15. Wirklich vergleichen kann man diese beiden Lösungen nicht, aber das darf am Ende natürlich jeder für sich selbst entscheiden.

Achtung: um den Skill auf einem Fire Tablet zu starten, muss der Aufruf mit “_Alexa, starte Mein Dashboard Skill_“ erfolgen. Das “_Skill_“ am Ende des Aufrufs ist wichtig! Läßt man das Wort weg, dann versucht Alexa, eine App auf dem Tablet zu starten - und das ist sehr wahrscheinlich nicht das, was man möchte.

“Pizza Party” - Sprachanwendungen mit Jovo

Mit dem Framework Jovo können wir Sprachanwendungen schreiben, die auf mehreren Plattformen funktionieren. Zum Beispiel können aus einer Codebasis heraus alle nötigen Artefakte für Alexa und Google Assistant generiert werden.

Für den Einstieg in die damit verbundenen Konzepte sollte man aber etwas Zeit einplanen. Damit es für interessierte Entwickler schneller geht, habe ich auf Github ein umfassendes Repository “Pizza Party“ erstellt, in dem ich viele Beispiele aus Forenbeiträgen, Chats und der offiziellen Dokumentation zu einer lauffähigen Anwendung zusammengefügt habe. Unter anderem werden Features wie Stages, i18n, mehrere Plattformen und APL out-of-the-box unterstützt.

Schließlich demonstriert das Template auch, wie all die vielen Settings für die Shop/Store-Einträge von einer Dateibasis aus konfiguriert werden können. Insbesondere dann, wenn man mit mehreren Locales arbeitet, spart dieser Ansatz sehr viel Zeit bei der Wartung der Anwendung.

Die Funktionalität wird fortlaufend erweitert. Es lohnt sich also, regelmäßig vorbeizuschauen:

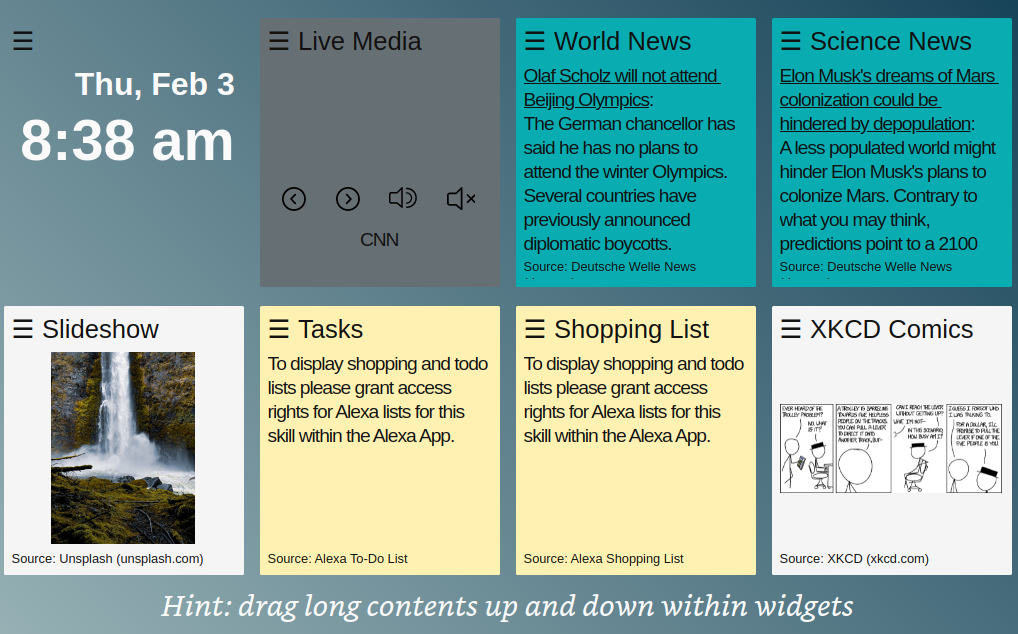

Neue Widgets für “Mein Dashboard” / “My Dashboard”

Seit dieser Woche gibt es neue Widgets im Alexa Skill “Mein Dashboard” / “My Dashboard”:

- ISS Tracker mit Landkarte und automatischer Aktualisierung

- Würfel: zufällige Zahl zwischen 1 und 6 anzeigen (mit Animation)

- Wirf eine Münze / “Ja” oder “Nein” (mit Animation)

- Bitcoin Tracker: Anzeige der Werte für Euro und Dollar

- System: zeige eine Reihe von Systemeigenschaften von dem verwendeten Gerät an

- Einstellungen: Das ist noch experimentell. Bis jetzt ist nur die Auswahl einer Hintergrundfarbe möglich. Der Wert wird auch noch nicht gespeichert.

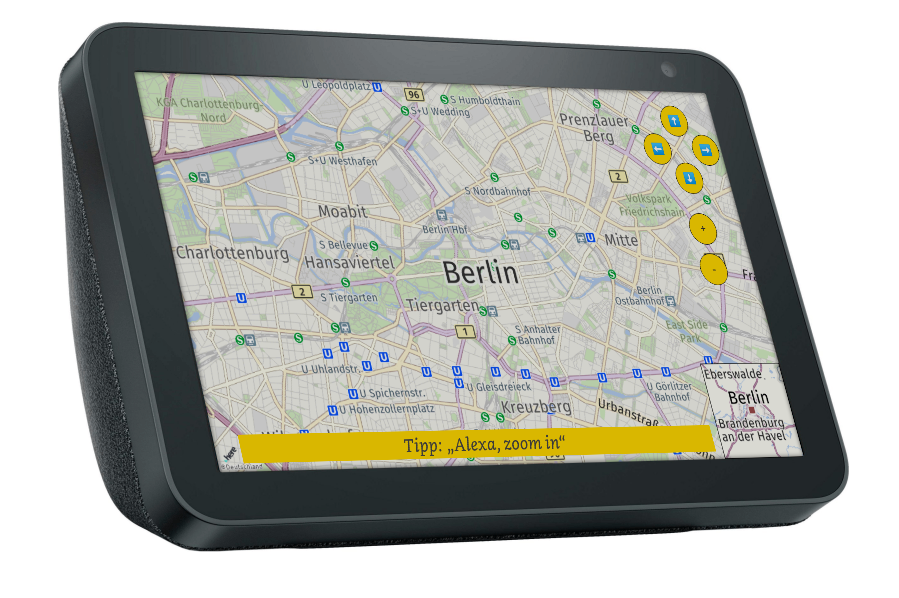

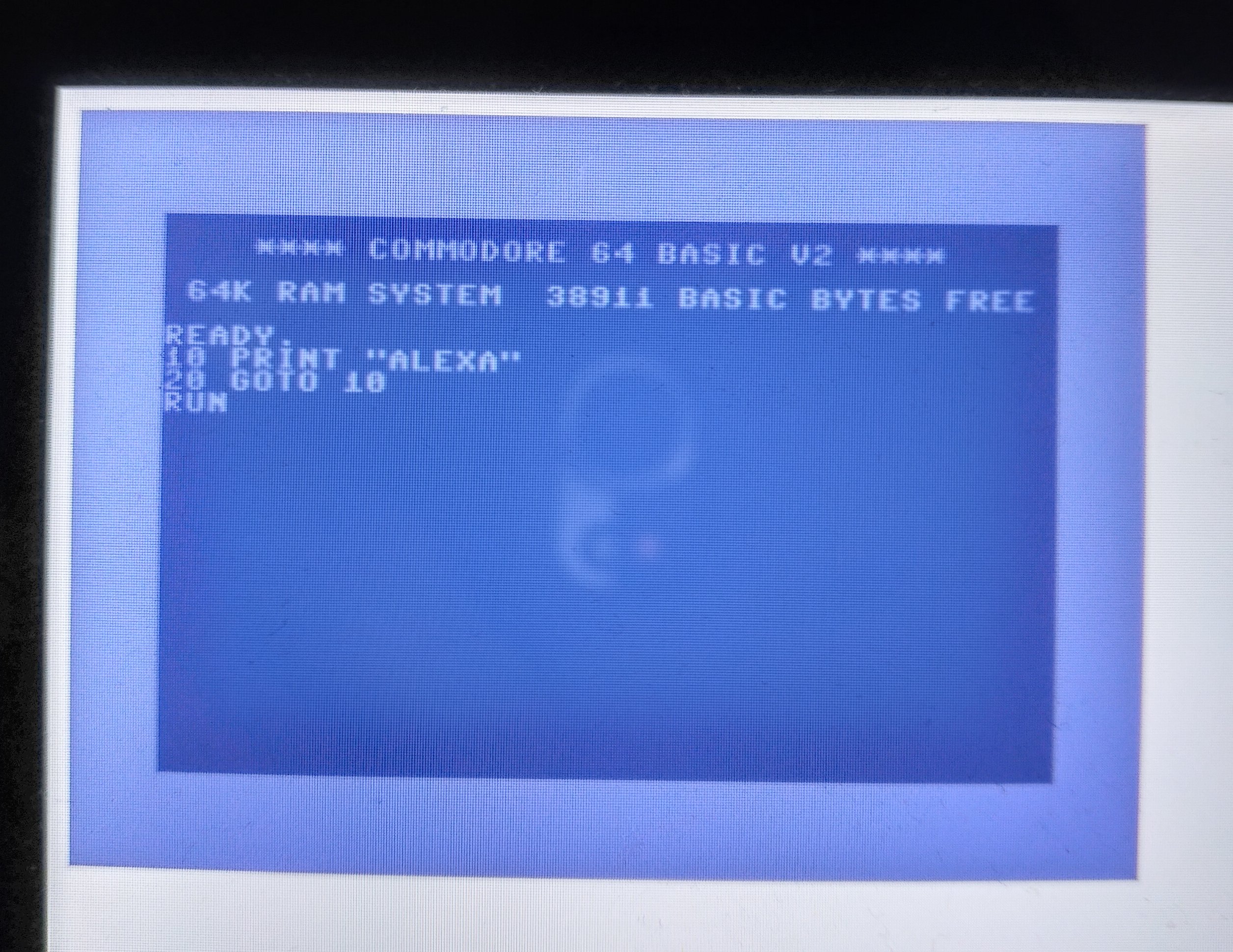

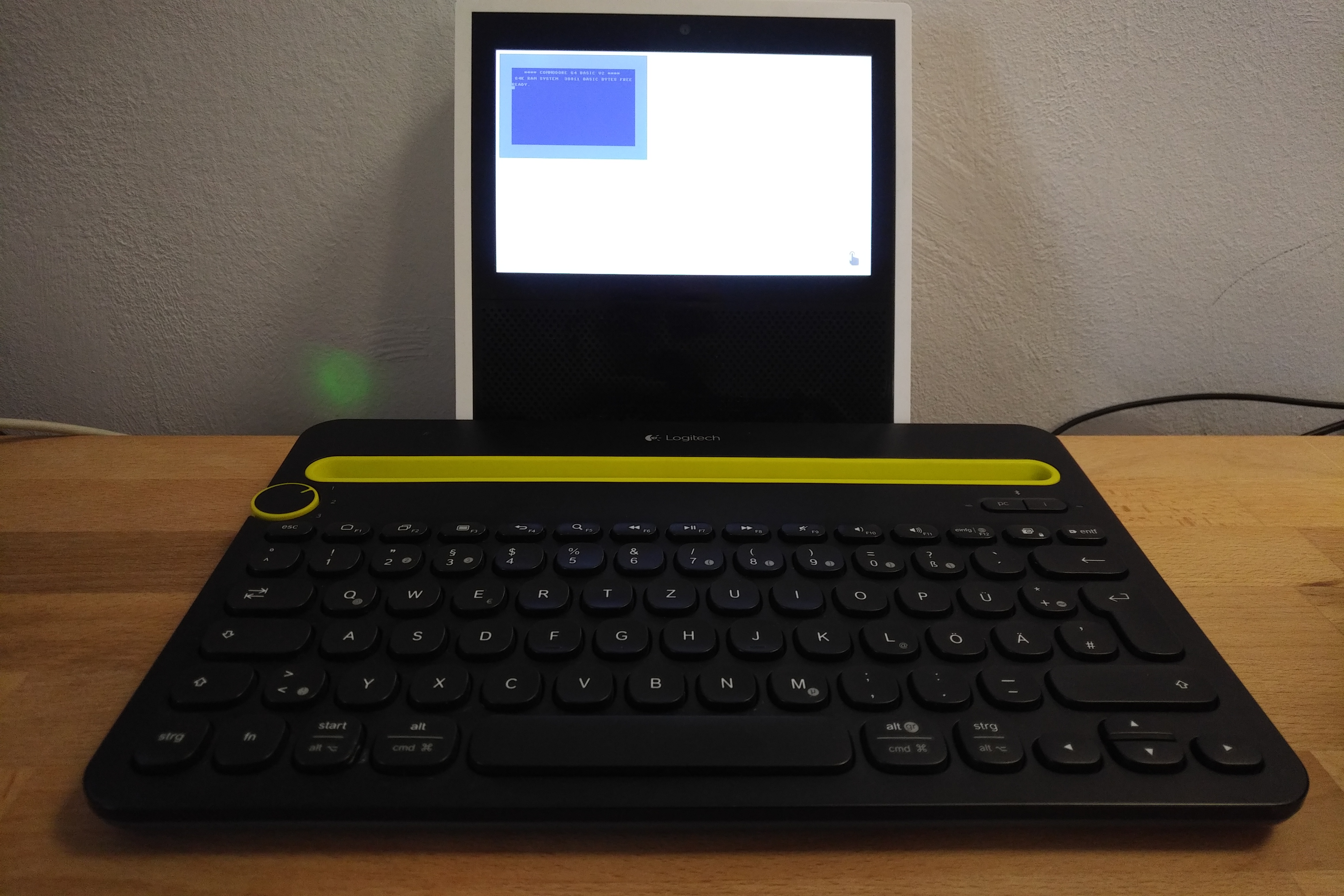

Commodore 64 Emulation auf einem Echo Show

Einen anderen Computer auf einem Echo Show emulieren - geht das? Wenn man die vorhandenen losen Enden richtig zusammenführt, dann bekommt man so etwas tatsächlich zum Laufen, inklusive einer akzeptablen Performance und Soundchip-Emulation.

Hier ist das Rezept:

- Verbinde in den Systemeinstellungen vom Echo Show ein Bluetooth Keyboard mit dem Gerät (ja, das geht wirklich!)

- Wir suchen uns eine Internetseite, die es ermöglicht, C64-Spiele online zu spielen.

- Von einem APL Dokument aus kann mit dem Befehl “OpenURL“ diese Internetadresse geladen und in dem eingebauten Browser dargestellt werden.

- Wir schreiben einen Skill, der das APL Dokument darstellt.

Falls Ihr keine Lust habt, dass alles selber zusammenzuschrauben, dann hier ein Tipp: in dem Alexa Skill “Mein Dashboard“ ist alles schon fertig vorbereitet. Ihr müsst den Aktionsknopf nur antippen.

Nachfolgend findet Ihr einen Film, auf dem Ihr zusehen könnt, wie ich Frogger auf einem C64 spiele:

Alexa Skill “Mein Dashboard” / “My Dashboard”

Seit der Alexa Live 2021 stehen APL Widgets ganz weit oben auf dem Wunschzettel vieler Benutzer. Aber nicht jeder hat einen Echo Show 15 bei sich daheim stehen - vorausgesetzt man lebt überhaupt in einem Teil der Welt, in dem das Gerät schon verfübar ist.

Diese Situation hat mich zu der Frage geführt, wie weit man bei dem Thema Widgets kommen kann, wenn man mit dem arbeitet, was APL von Haus aus mitbringt.

Ein erstes Ergebnis ist der Alexa Skill “Mein Dashboard” / “My Dashboard”. Folgendes ist dabei herausgekommen:

Eine alternative Ansicht mit weniger Widgets gibt es auch:

Ein ausführliche Anleitung zu dem Skill findet Ihr hier (deutsch) und hier (englisch).

Der Skill ist für alle deutschen und englischen Locales verfügbar:

- 🇩🇪 https://www.amazon.de/gp/product/B09R9TW9S8 (de-DE)

- 🇺🇸 https://www.amazon.com/gp/product/B09R9TW9S8 (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B09R9TW9S8 (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B09R9TW9S8 (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B09R9TW9S8 (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B09R9TW9S8 (en-AU)

Oder einfach per QuickLink.

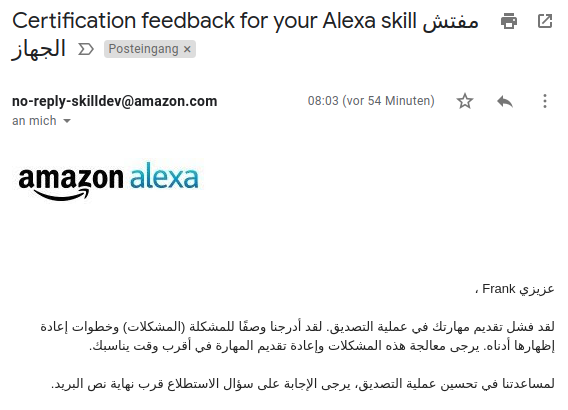

Arabische Alexa Skills

Ganz klar: ich spreche kein Arabisch. Aber wenn Alexa das nun gelernt hat, dann sollte es doch nicht so schwierig sein, einen einfachen Skill wie “APL Doctor“ auf Arabisch zu übersetzen? Dachte ich mir jedenfalls. Aber im Detail stößt man dann doch - natürlich - auf viele Schwierigkeiten, bei denen Google-Translate einem nicht helfen kann 🙂

Heute habe ich mein erstes “Certification Feedback“ bekommen, das sieht dann so aus:

Was steht da drin? Die Mail enthält weiter unten auch eine englische Version, die weiter hilft. Dort lerne ich: “Certification Failed“, weil es mit dem Launch Request nicht klappt.

“اليكسا افتحي مفتش الجهاز”Das ist in der Tat schwierig zu testen, wenn man selber nicht Arabisch spricht. In der Developer Console klappt es, wenn man es textuell eingibt.

Nun beginnt die Fehlersuche. Ich bleibe am Ball und werde berichten …

“GPT-3” und Alexa

Es gibt keinen Zweifel daran, dass GPT-3, die neueste und leistungsstärkste Version der Natural Language Processing (NLP) Technologie von OpenAI, die Welt der künstlichen Intelligenz revolutioniert hat. Die Wartezeit, um Zugang zu dieser bahnbrechenden Technologie zu erhalten, hat viele Entwickler und Unternehmen dazu veranlasst, ungeduldig darauf zu warten, dass ihre Anwendungen und Projekte durch die Leistungsfähigkeit von GPT-3 unterstützt werden.

Nach über einem Jahr Wartezeit habe ich nun endlich auch Zugriff auf GPT-3 bekommen und konnte mit den Möglichkeiten experimentieren. Interessiert hat mich dabei auch, wie man diese Technologie vielleicht im Zusammenhang mit Alexa nutzen kann.

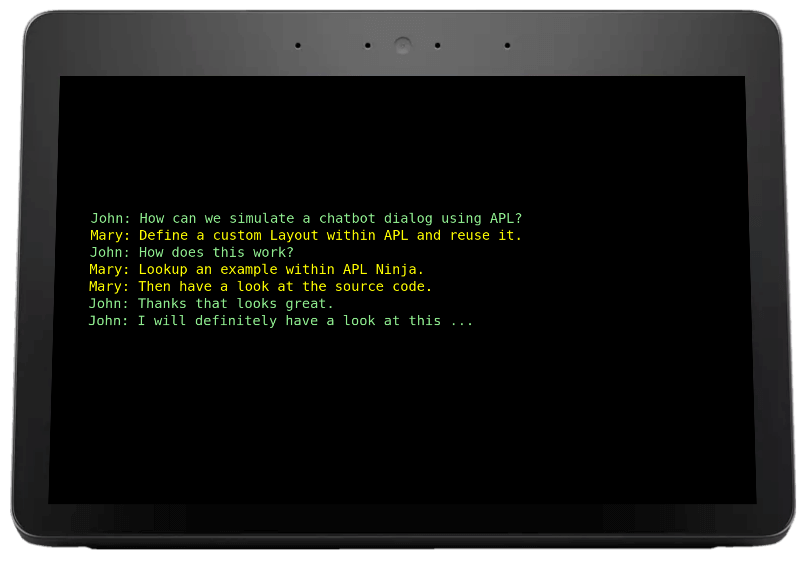

Unter anderem habe ich GPT-3 dazu benutzt, einen “Alexa APL Chatbot” zu bauen oder automatisch Anwendungsfallbeschreibungen für Alexa Skills zu generieren. Zu dem zweiten Szenario habe ich einen Artikel auf LinkedIn veröffentlicht.

So sehr ich davon beeindruckt bin, wie man mit GPT-3 korrekt ausehende Strukturen erzeugen kann, so sehr ist bei meinen Experimenten auch deutlich geworden, dass die Semantik der syntaktisch korrekten Sätze in der Regel völlig kaputt ist: Natürlich hat GPT-3 keine Ahnung davon, was es da sagt. Und so kann es dann eben passieren, dass das System schön verpackten Unsinn generiert.

Was für Anwendungsfälle kommen einem für so eine Technologie in den Sinn?

- Eine “Bullshit Bingo” Matrix mit Inhalt füllen

- Testdaten generieren

- Zufällige Fake-Profile für eine Webseite generieren

- Redemanuskripte für Politiker verfassen

- Massenhaft Inhalt für Honeypot-Webseiten generieren, die wie echte Seiten aussehen, aber eigentlich nur zufällige Texte enthalten.

- Fake Blogs erstellen mit vielen Artikeln zum Beispiel zu einem Thema wie “Alexa”.

- Eine “Inspirationsmaschine” bauen, die (vielleicht) neue Ansätze und Ideen für bekannte Probleme formuliert.

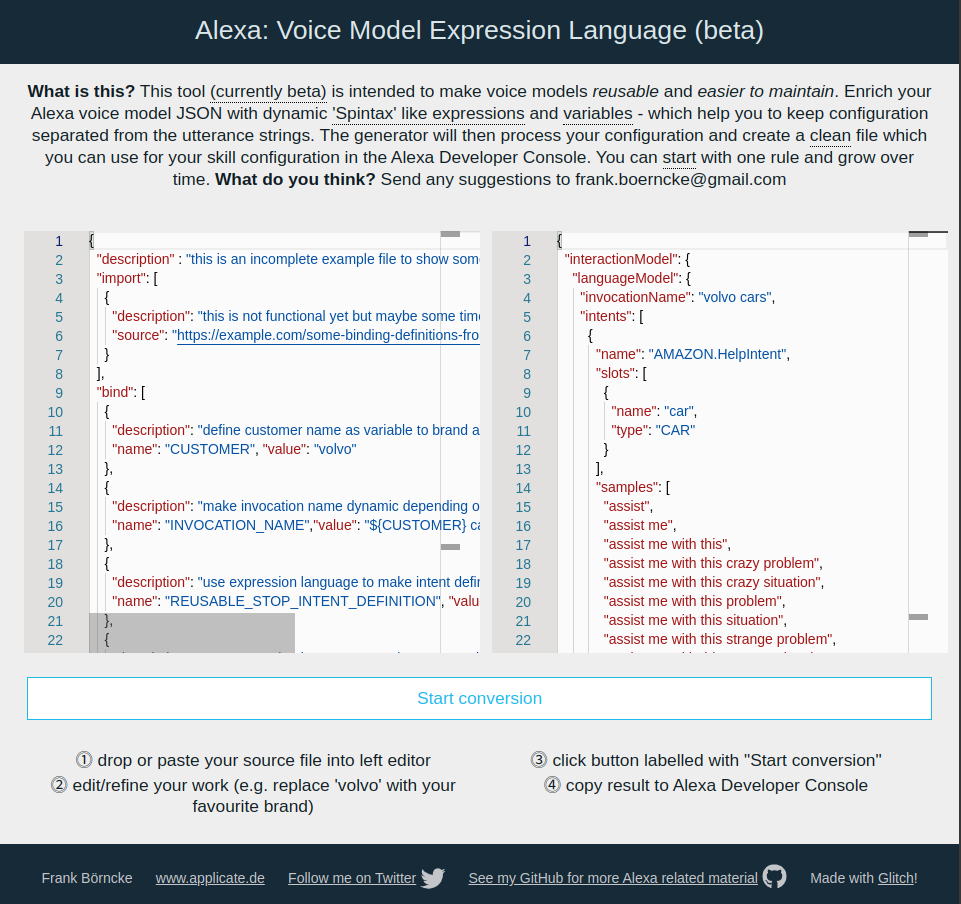

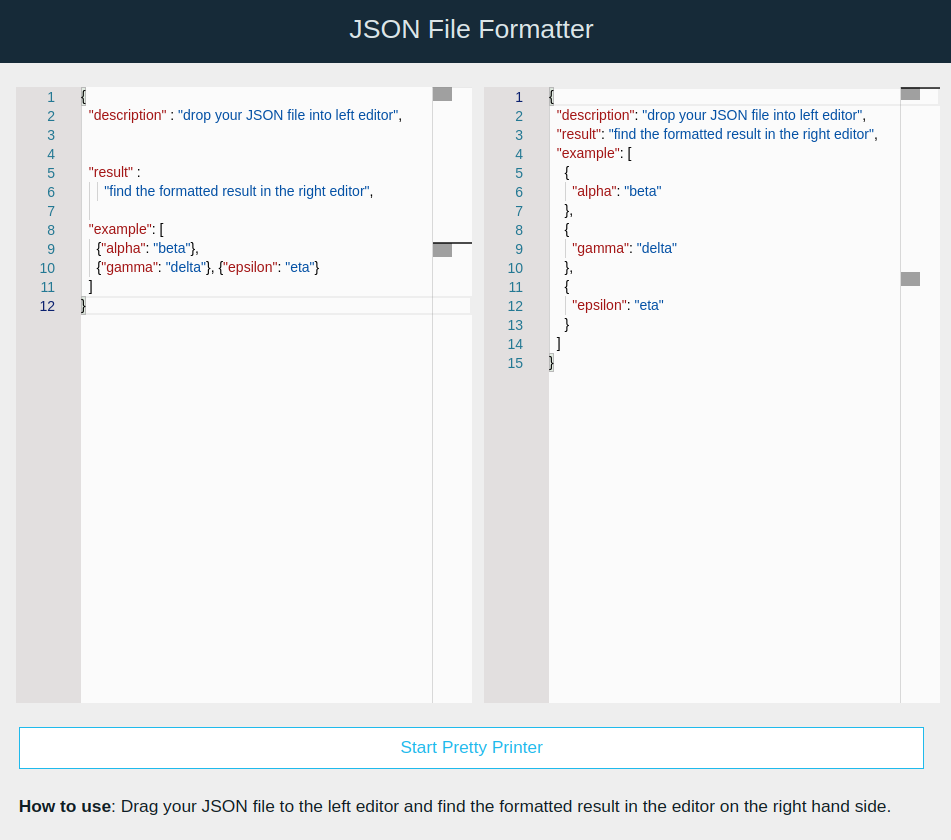

Artikel auf LinkedIn über “Voice Model Expression Language”

Über mein Alexa Tool “voicemodel.applicate.de“ habe ich einen Artikel auf LinkedIn veröffentlicht und auf verschiedenen Kanälen dafür eine Menge Zuspruch bekommen.

Mit der Expression Language für Voicemodels werden lange Dateien wieder wartbar. Auch für die Lokalisierung bietet dieser Ansatz Vorteile. Bei der Übersetzung vom Alexa Skill Universallexikon auf Spanisch habe ich diesen Ansatz zusammen mit Xavier Portilla Edo erfolgreich verwendet.

Wer diese Funktion nicht nutzen möchte, der kann das Tool aber auch einfach nur als “Pretty Printer” verwenden, um in seinen gewachsenen JSON-Files aufzuräumen. Das erleichtert den Durchblick enorm.

Jetzt auch Spanisch: Alexa Skill ‘Enciclopedia Universal’

Meine eigenen Spanischkenntnisse sind bestenfalls rudimentär. So freue ich mich sehr, dass ich mit der großartigen Unterstützung von Xavier Portilla Edo meinen Skill “Universallexikon” nicht nur in Deutsch und English sondern nun auch in Spanisch veröffentlichen kann. Dort hört er auf den Invocation Name “Enciclopedia Universal“.

Das ist mein erster spanischer Alexa Skill.

Danke Xavier!

Hier der QuickLink:

https://alexa-skills.amazon.com/apis/custom/skills/amzn1.ask.skill.901f981c-7dba-4c62-97a5-262da8dd5ebc/launch

Wunschzettel zur Alexa Live 2021

Bald ist Alexa Live 2021. Einen Wunschzettel dazu mit meinen Wünschen und Erwartungen habe ich bei LinkedIn veröffentlicht. In den Kommentaren dort könnte Ihr Eure eigenen Punkte ergänzen. Oder einfach auf das Bild klicken:

RSS Feed eingerichtet

Das war schon lange überfällig: dieser Webauftritt hat nun auch endlich einen RSS-Feed.

Update Alexa Skill “R2D2” nun für englische Locales

Einer meiner ersten (und von der Implementierung her einfachsten) Alexa Skills ist einR2D2-Zwitscherer. Aus irgendwelchen Gründen war dieser jahrelang nur in Deutschland verfügbar, jetzt habe ich ihn auch für englische Locales portiert:

Im Skill Store gibt es “R2D2 - Ask me Anything!“ hier:

- 🇩🇪 https://www.amazon.de/gp/product/B06XYQHPM9 (de-DE)

- 🇺🇸 https://www.amazon.com/gp/product/B06XYQHPM9 (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B06XYQHPM9 (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B06XYQHPM9 (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B06XYQHPM9 (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B06XYQHPM9 (en-AU)

Neuer Alexa Skill “Trek Base”

Dieser Skill beantwortet Fragen zu Protagonisten, Filmen, Serien, außerirdischen Völkern und Technologien aus dem Star Trek Universum. Die Informationen stammen aus dem Korpus von Wikipedia.

Der Skill ist derzeit ausschließlich in englischer Sprache verfügbar.

Beispiele:

- “_Search for Jean-Luc Picard_“

- “What is Star Trek Voyager“

- “Tell me something about the movie ‘First Contact’“

Im Skill Store:

🇺🇸 https://www.amazon.com/gp/product/B095K6N8SS (en-US)

🇬🇧 https://www.amazon.co.uk/gp/product/B095K6N8SS (en-GB)

🇨🇦 https://www.amazon.ca/gp/product/B095K6N8SS (en-CA)

🇮🇳 https://www.amazon.in/gp/product/B095K6N8SS (en-IN)

🇦🇺 https://www.amazon.com.au/gp/product/B095K6N8SS (en-AU)

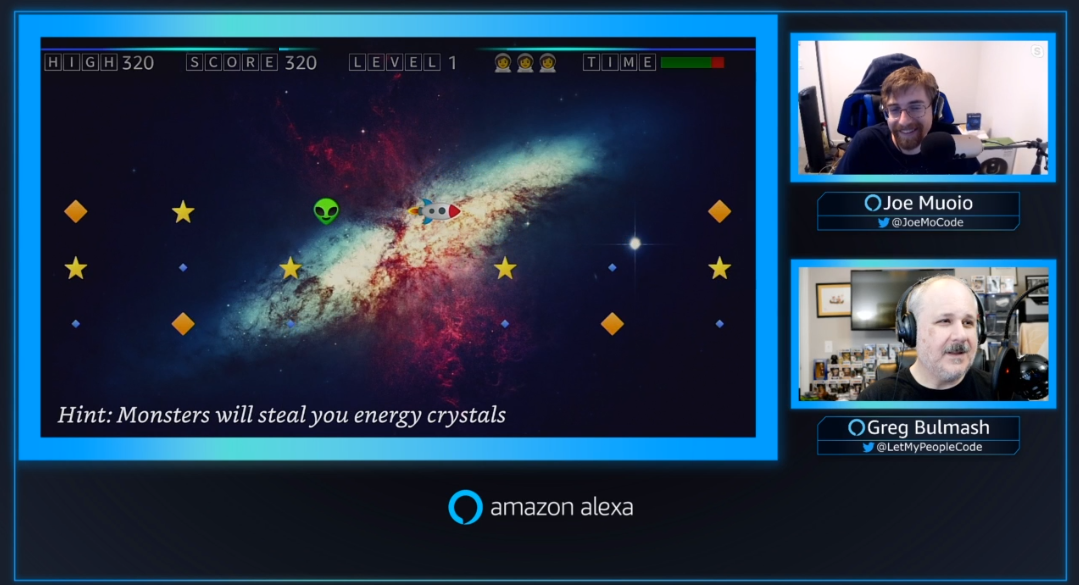

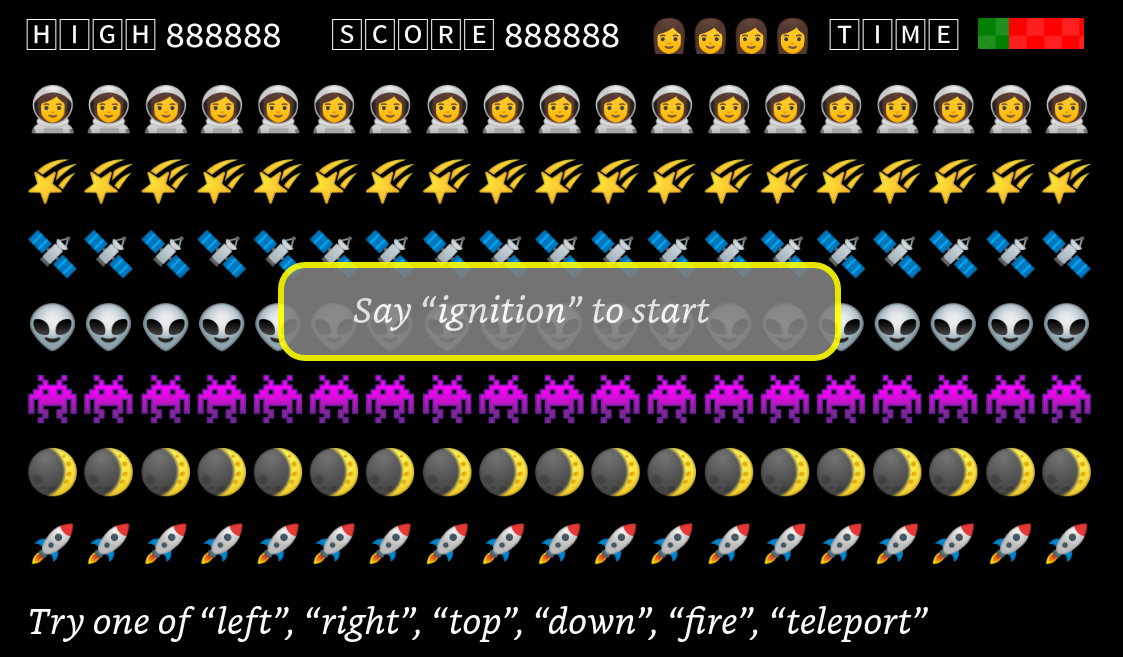

“ToolBox” kann jetzt “Pong”

Alexander Martin (der Erfinder von APL.Ninja) hat mir erlaubt, einige seiner APL Dokumente mit in ToolBox einzubinden. Damit ist es nun unter anderem auch möglich, bei einer Programmierpause das Spiel “Pong“ auf einem Echo Show zu starten. Gleichzeitig demonstrieren diese Beispiele, was alles mit Hilfe von APL realisiert werden kann. Zu Pong hat Alexander einen lesenswerten Artikel veröffentlicht, den ich zugleich jedem Einsteiger in das Thema APL mit gutem Gewissen empfehlen kann.

Aufruf in Deutschland:

"Alexa, starte ToolBox und spiele Pong"Im Skill Store:

- 🇩🇪 https://www.amazon.de/gp/product/B091L5WB5S (de-DE)

- 🇺🇸 https://www.amazon.com/gp/product/B091L5WB5S (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B091L5WB5S (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B091L5WB5S (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B091L5WB5S (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B091L5WB5S (en-AU)

Neuer Alexa Skill “Cinema Space”

Die NASA verwaltet ein umfangreiches öffentliches Videoarchiv mit Material aus den letzten Jahrzehnten. Das ist eine echte Fundgrube für alle, die sich für die Themen Weltraum und Raumfahrt interessieren. Mit “Cinema Space“ kann man das Archiv nach gesprochenen Suchbegriffen durchforsten und die Videos direkt auf dem Gerät ansehen.

Aufruf:

"Alexa, open Cinema Space"Im Skill Store:

🇺🇸 https://www.amazon.com/gp/product/B094NMZW3M (en-US)

🇬🇧 https://www.amazon.co.uk/gp/product/B094NMZW3M (en-GB)

🇨🇦 https://www.amazon.ca/gp/product/B094NMZW3M (en-CA)

🇮🇳 https://www.amazon.in/gp/product/B094NMZW3M (en-IN)

🇦🇺 https://www.amazon.com.au/gp/product/B094NMZW3M (en-AU)

Tipp: Da die Skill-Zertifizierungsstelle keine englischen Inhalte in deutschen Skills mag, kann ich den Skill nicht für Deutschland anbieten. Workaround: Ihr könnt einer deutsche Alexa in den Einstellungen beibringen, sowohl auf englische wie auch auf deutsche Befehle zu hören. Dann klappt es auch in “DE” mit “Cinema Space“. Leider werden die englischen Texte dann unter Umständen mit deutschem Akzent vorgelesen, aber damit kann man vielleicht leben 🙂

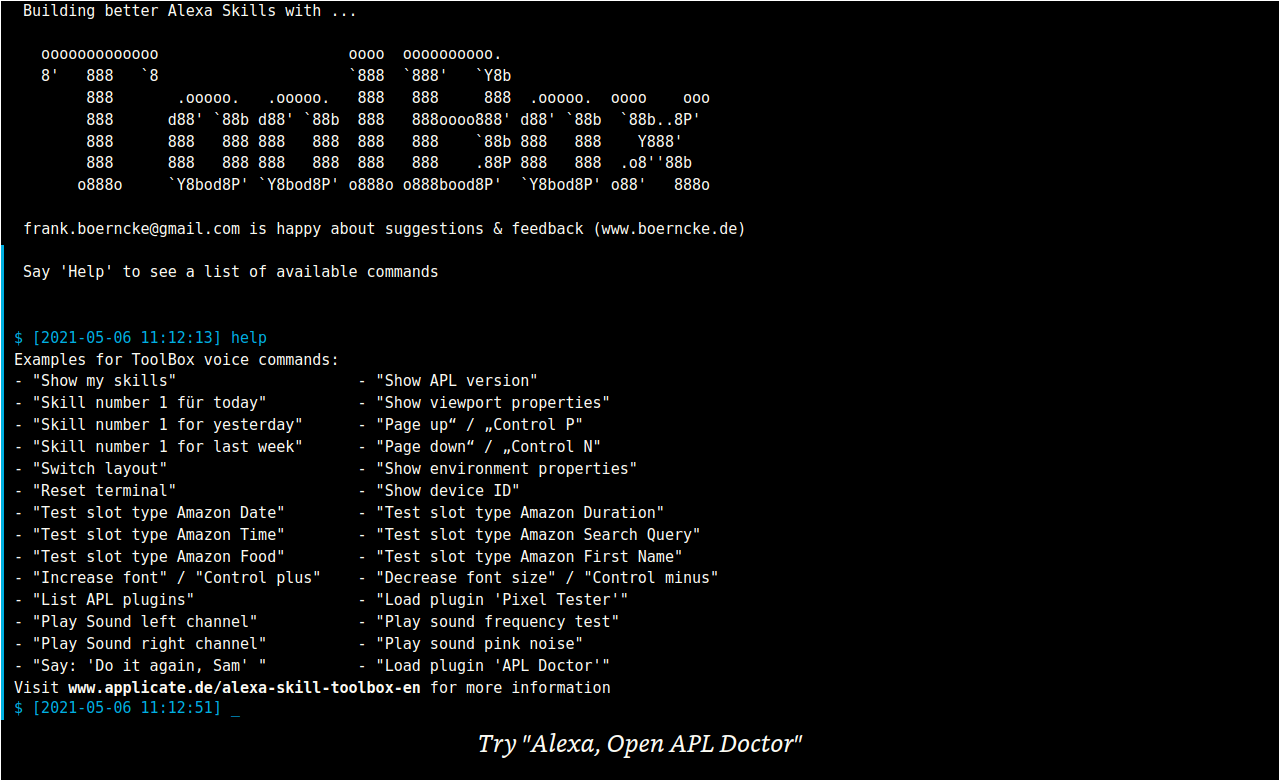

Update Alexa Skill “ToolBox”

Der Alexa Skill “ToolBox“ hat dazu gelernt. In der neuen Version können Stand-alone-APL-Dokumente wie Plugins eingebunden werden, um die Funktionalität des Skills zu erweitern. Zu den ersten Plugins zählen auch der “APL Doktor“.

Mit verschiedenen Sound-Tests ist es nun einfach möglich, sein Audio-Setup zu testen und zwei neue Slot-Type-Tests wurden auch ergänzt.

Chatbot mit APL visualisieren

Einen Chatbot in Alexa zu implementieren ist eine Sache, aber wie kann man einen Dialog visualisieren?

Eine passenden Style dazu habe ich unter APL.Ninja veröffentlicht. Der Text wird wie bei einer Schreibmaschine animiert, die Geschwindikeit der Animation kann über Parameter konfiguriert werden:

Update Alexa Skill “Universallexikon” / “Universal Explainer”

Der Alexa Skill “Universallexikon“ ist jetzt auch in englischer Sprache verfügbar und hört dort auf den Namen “Universal Explainer“.

Wie man den Skill verwendet, welche Tricks es gibt und was der Skill anders macht als andere Wikipedia-Skills, das kann man auf einer deutschen Informationsseite oder alternativ auch in englischer Sprache erfahren.

Im Skill Store:

🇩🇪 https://www.amazon.de/gp/product/B07166W6VL (de-DE)

🇺🇸 https://www.amazon.com/gp/product/B07166W6VL (en-US)

🇬🇧 https://www.amazon.co.uk/gp/product/B07166W6VL (en-GB)

🇨🇦 https://www.amazon.ca/gp/product/B07166W6VL (en-CA)

🇮🇳 https://www.amazon.in/gp/product/B07166W6VL (en-IN)

🇦🇺 https://www.amazon.com.au/gp/product/B07166W6VL (en-AU)

Update Alexa Skill “APL Doktor” / “APL Doctor”

Mit der Einführung von “APL 1.6” und der Definition von zusätzlichen Geräteprofilen war es überfällig, den Alexa Skill “APL Doktor“ / “APL Doctor“ zu aktualisieren.

Das neue Design sieht nun so aus:

Aktualisiert wurde auch die englische Beschreibung von dem SKill.

- 🇩🇪 https://www.amazon.de/gp/product/B08BZ9NLCH (de-DE)

- 🇺🇸 https://www.amazon.com/gp/product/B08BZ9NLCH (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B08BZ9NLCH (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B08BZ9NLCH (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B08BZ9NLCH (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B08BZ9NLCH (en-AU)

Zu Gast im Podcast “Voice Tech Talk”

Vergangene Woche war ich zusammen mit Alexander Martin zu Gast bei Daniel Mittendorf im Podcast “Voice Tech Talk“ von beyond touch. Wir reden über Voice, Alexa, APL, Multimodalität und APL Ninja:

Mehr Informationen gibt es auf meiner Podcast-Seite mit zusätzlichen Informationen und Transkriptionen.

Update Alexa Skill “Universallexikon”

Den Alexa Skill “Universallexikon“ habe ich lange nicht mehr angefasst, nun ist er in einer überarbeiteten Version live gegangen. Es gibt nun zahlreiche zusätzliche Anwendungsbeispiele und Vorschläge. Das Sprachmodell wurde deutlich verfeinert und erfasst nun viel mehr Abfragen, als zuvor. Die Ergebnisse werden nun auch etwas schneller vorgelesen.

Das besondere an diesem Skill ist, dass nicht nur nach einem Stichwort, sondern auch nach Kontext gesucht werden kann.

Hier einige Beispiele:

"Alexa, frage Universallexikon, was ist Titanic als Schiff"==> gefunden wird eine Artikel über das Schiff “RMS Titanic”

"Alexa, frage Universallexikon, was ist Titanic als Film"==> gefunden wird eine Eintrag zu dem Film “Titanic” von 1997

"Alexa, frage Universallexikon, was ist Titanic als Zeitschrift"==> gefunden wird eine Eintrag zum Satire-Magazin “Titanic”

Aufruf in Deutschland mit dem Sprachbefehl:

"Alexa, starte Universallexikon"Im Skill Store:

🇩🇪 https://www.amazon.de/gp/product/B07166W6VL (de-DE)

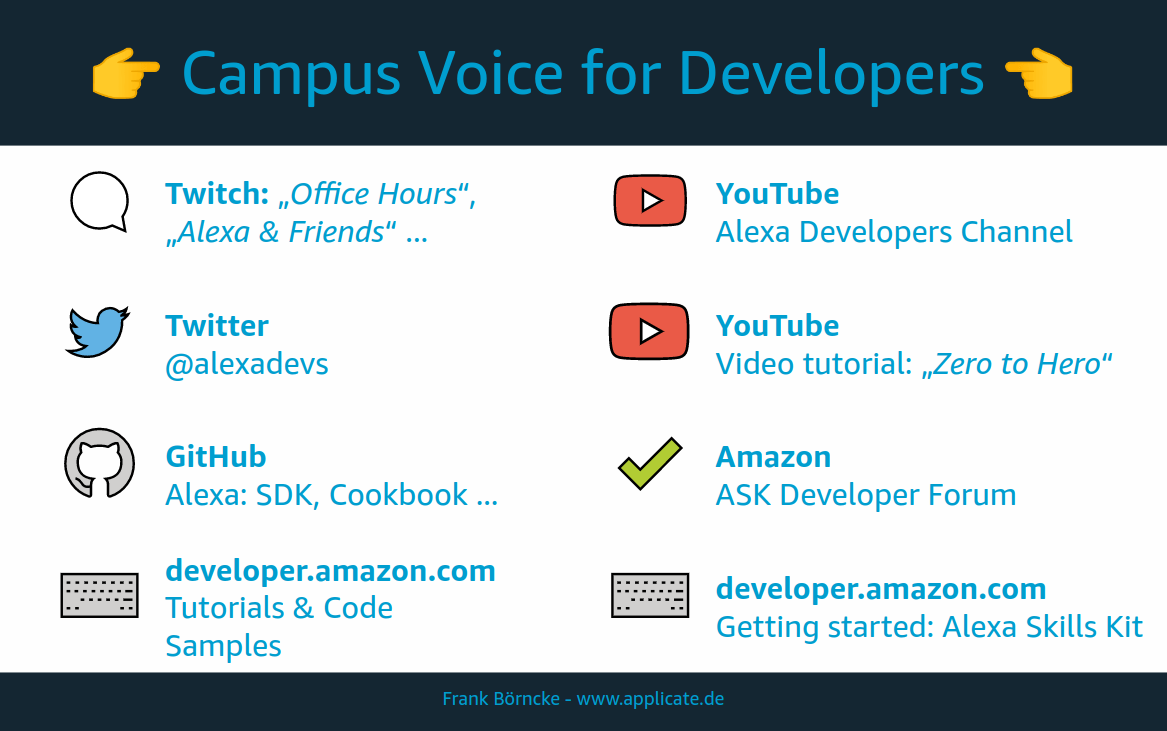

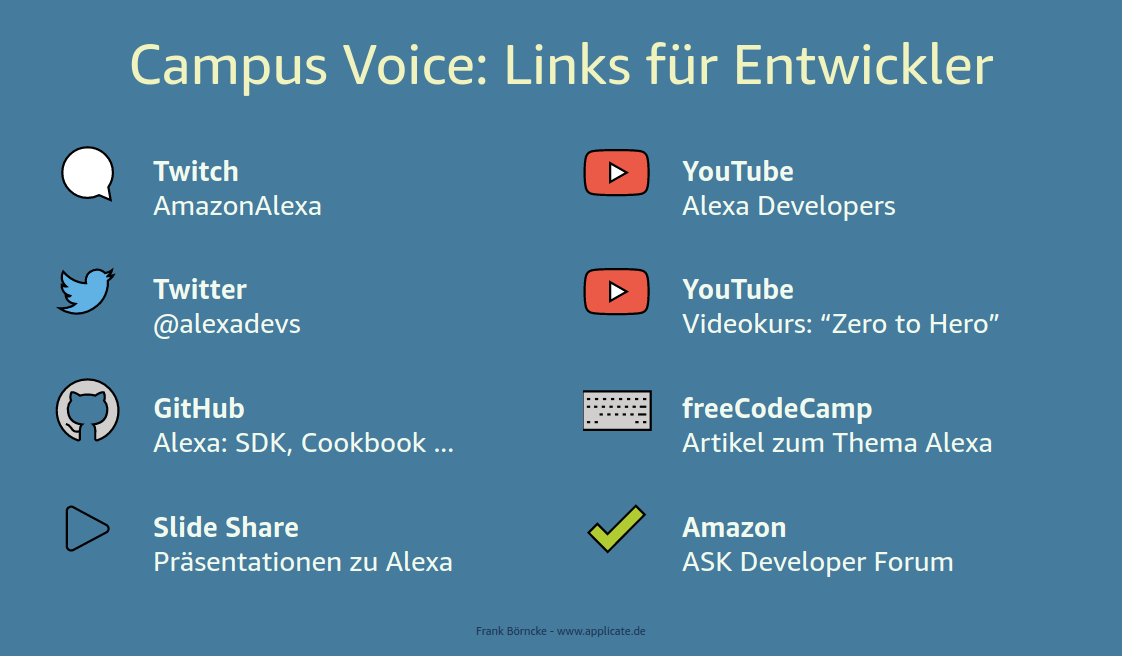

Update Alexa Skill “Campus Voice”

Den Alexa Skill “Campus Voice“ gibt es jetzt in einer überarbeiteten Version. Mal eben die letzten Folgen der “Office Hours“ oder “Alexa & Friends“ auf Twitch ansehen? Das geht jetzt ganz einfach per Sprachbefehl. Nach dem Aufruf von Campus Voice erscheint eine Übersicht mit interessanten Links für Entwickler (siehe Bild oben) und per Touch kann man dann die Inhalte direkt auf dem Echo Show benutzen.

Aufruf in Deutschland mit dem Sprachbefehl:

"Alexa, starte Campus Voice"Aufruf international:

"Alexa, open Campus Voice"Im Skill Store:

🇩🇪 https://www.amazon.de/gp/product/B08C9KMVCG (de-DE)

Erstes Treffen von #VoiceLunch DACH

Am 14.4.2021 fand das erste Online-Treffen von #VoiceLunch DACH statt mit über 30 Teilnehmern aus Deutschland, Österreich und der Schweiz.

Wer den Kick-Off-Termin verpasst hat und beim nächsten Treffen mit dabei sein möchte, der kann sich hier anmelden - oder einfach unten auf das Bild klicken:

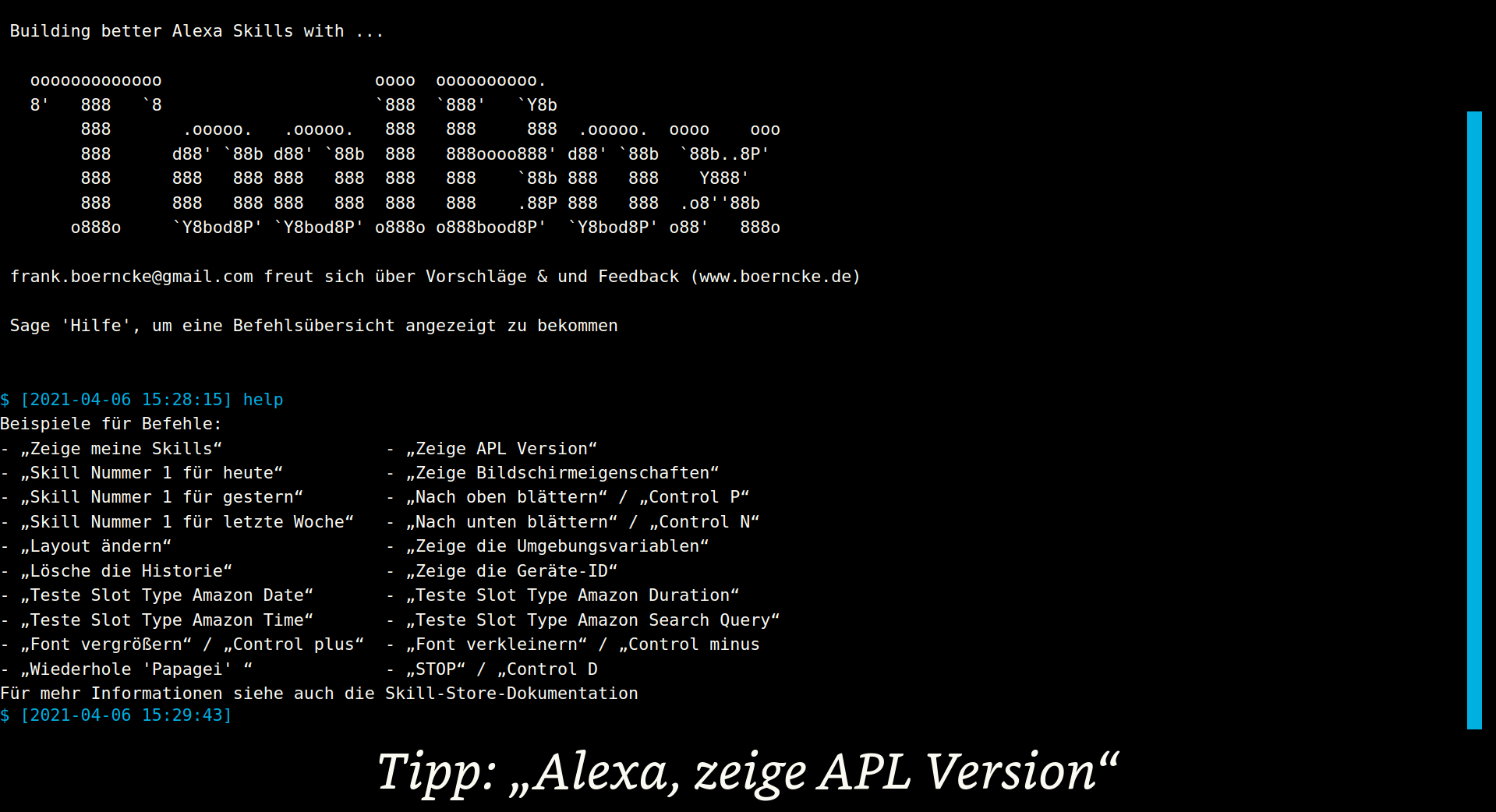

Neuer Alexa Skill “ToolBox”

Der Alexa Skill “ToolBox“ sammelt viele Funktionen, die einem Alexa-Skill Entwickler die tägliche Arbeit erleichtern.

Von der Oberfläche her im Stil einer klassischen Kommandozeile gehalten kann der Benutzer nützliche Eigenschaften zu Geräten ermitteln und zusätzlich auch Zugriffszahlen zu den eigenen produktiven Skills abfragen (für die Analytics/Metrics-Funktion ist Account-Linking erforderlich).

Der Skill wird nach und nach erweitert und auch internationalisiert werden.

Aufruf in Deutschland

"Alexa, starte ToolBox"Im Skill Store:

🇩🇪 https://www.amazon.de/gp/product/B091L5WB5S (de-DE)

Hinweis 1: Die Abfrage von Metrics-Zahlen ist dahingehend eingeschränkt, dass die API nur begrenzt viele Zugriffe pro Zeiteinheit erlaubt. Aus diesem Grund kann es passieren, dass Zahlen manchmal nicht ermittelt werden können, dies eine Minute später aber problemlos funktioniert.

Hinweis 2: Eine neue und erweiterte Version von ToolBox befindet sich bereits in der Zertifizierung. Wer neugierig ist und vorab schon einmal sehen möchte, was die nächste Version an neuen Funktionen bringt, der mag sich vielleicht die deutsche Dokumentation oder die englische Variante dazu ansehen.

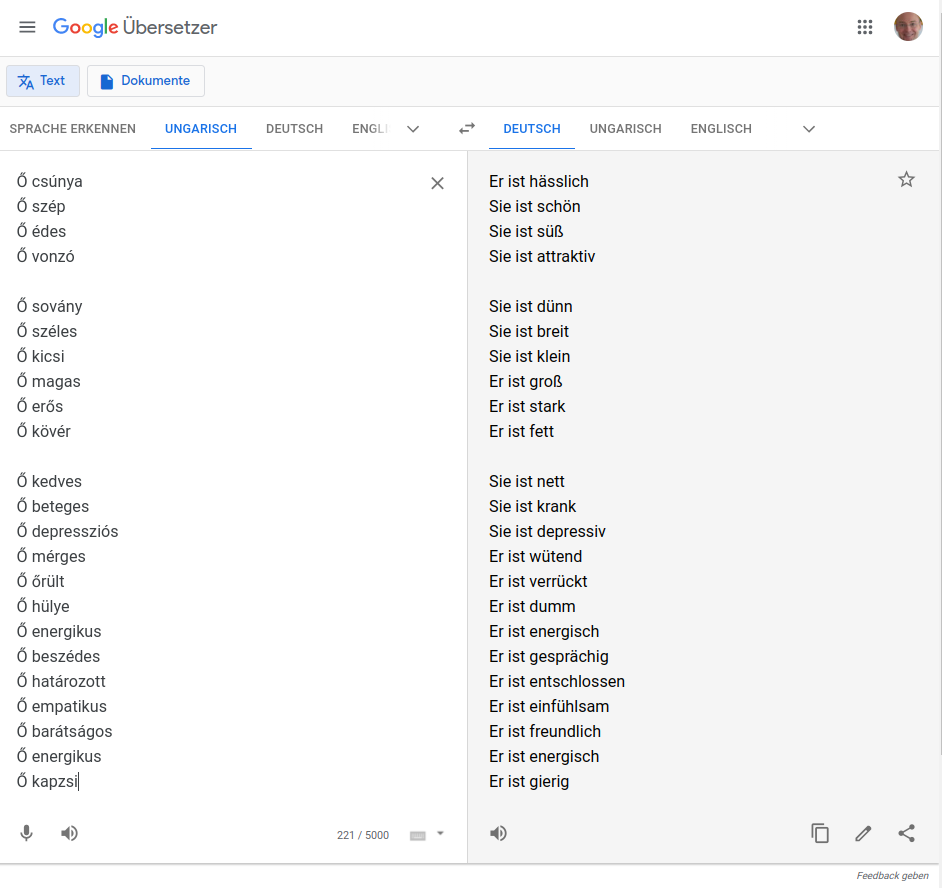

Gender Bias bei Google Translate

Zugegeben, Google Translate ist schon eine praktische Sache. Aber wenn der Eingabetext zu wenig Kontext liefert, dann muss die KI im Hintergrund mit Annahmen über die reale Welt arbeiten, um eine möglichst korrekte Übersetzung zu finden.

Was soll sie zum Beispiel machen, wenn das ungarische “Ő” sowohl “er”, wie auch “sie” bedeuten kann? Bezieht sich das Adjektiv danach dann eher auf einen Mann oder eine Frau?

Schauen wir uns mal an einigen Beispielen an, wie Google entscheidet:

Wer selber einmal damit herumspielen möcht, der findet nachfolgend die Wortliste zu diesem Beispiel:

Ő csúnya

Ő szép

Ő édes

Ő vonzó

Ő sovány

Ő széles

Ő kicsi

Ő magas

Ő erős

Ő kövér

Ő kedves

Ő beteges

Ő depressziós

Ő mérges

Ő őrült

Ő hülye

Ő energikus

Ő beszédes

Ő határozott

Ő empatikus

Ő barátságos

Ő energikus

Ő kapzsi

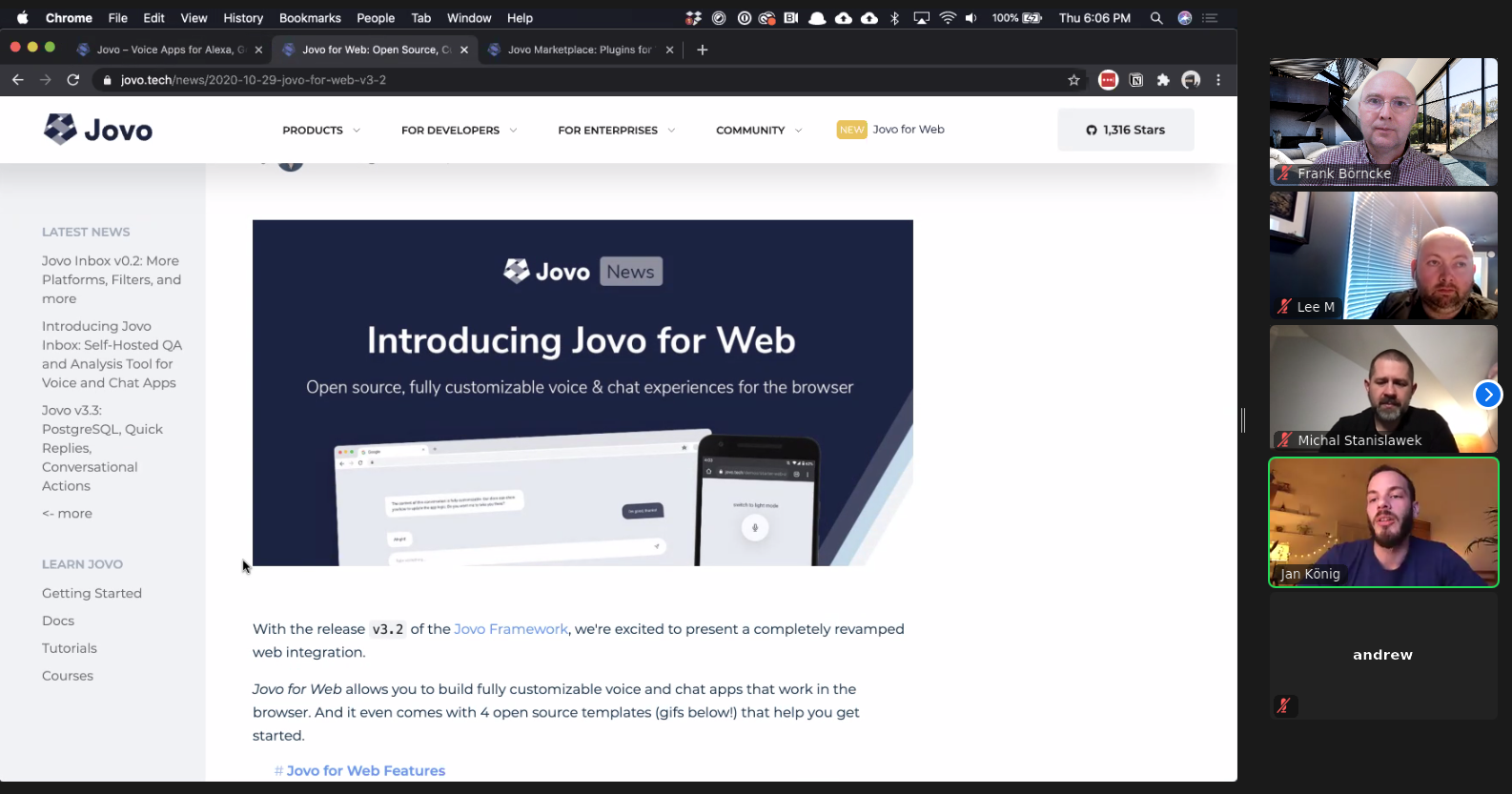

#VoiceLunch Developers zum Thema “Jovo”

Beim #VoiceLunch haben wir heute über das Jovo-Framework diskutiert. Jan König hat “Jovo for Web“ vorgestellt und für den Sommer den Sprung auf die Versionsnummer 4 angekündigt.

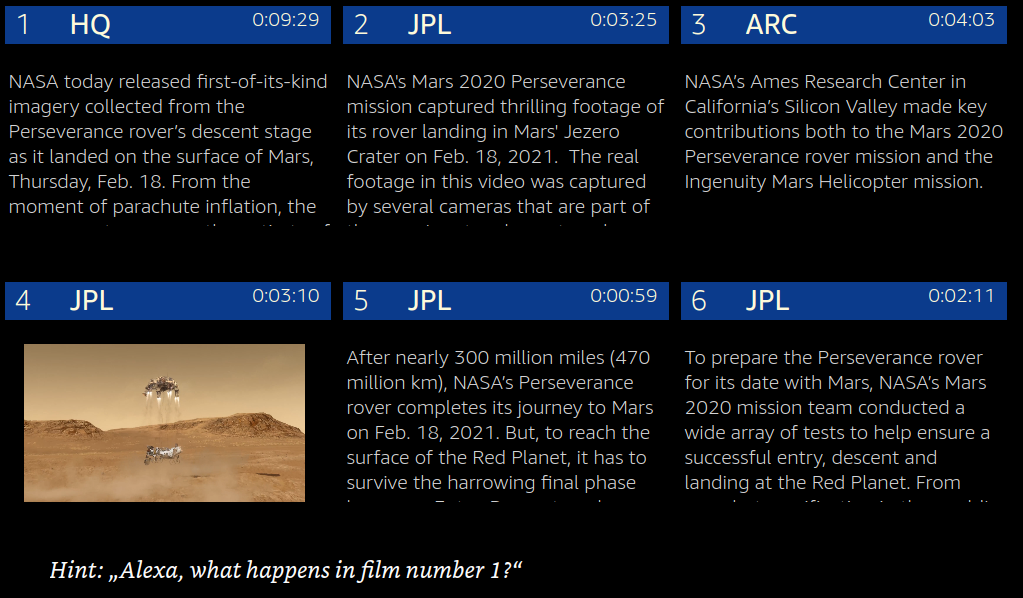

Neuer Alexa Skill “Mission Perseverance”

Der Alexa Skill “Mission Perseverance“ ermöglicht es, das öffentliche Film-Archiv der NASA zu der Mars-Mission Perseverance zu durchsuchen. Die Suchergebnisse können dann direkt auf einem Gerät mit Bildschirm angesehen werden.

- 🇺🇸 https://www.amazon.com/gp/product/B08XP7R29Z (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B08XP7R29Z (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B08XP7R29Z (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B08XP7R29Z (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B08XP7R29Z (en-AU)

Den Skill gibt es nur in englischer Sprache, weil die Zertifizierung es nicht mag, wenn ein deutscher Skill englische Inhalte transportiert.

So erging es mir im letzten Jahr bei der Zertifizierung von “Sky Pix“. Dieser Skill setzt auf dem Angebot von “APOD” (Astronomy Picture of the Day) auf. Dort musste ich den englischen Beschreibungstext der Bilder in der deutschen Version künstlich entfernen.

Bei alten Echo-Show Geräten kann es vorkommen, dass bestimmte Videos nicht abgespielt werden können.

Alle zwei Wochen am Donnerstag: #VoiceLunch for Developers

Achtung Technik: während man bei anderen #VoiceLunch Veranstaltungen nur selten eine Zeile Code zu sehen bekommt, sieht es bei VoiceLunch for Developers anders aus. Hier blickt man über den Tellerrand, geht tiefer in die Materie und teilt sein Wissen.

Wann und Wo?: Alle zwei Wochen am Donnerstag. Registrieren kann man sich hier

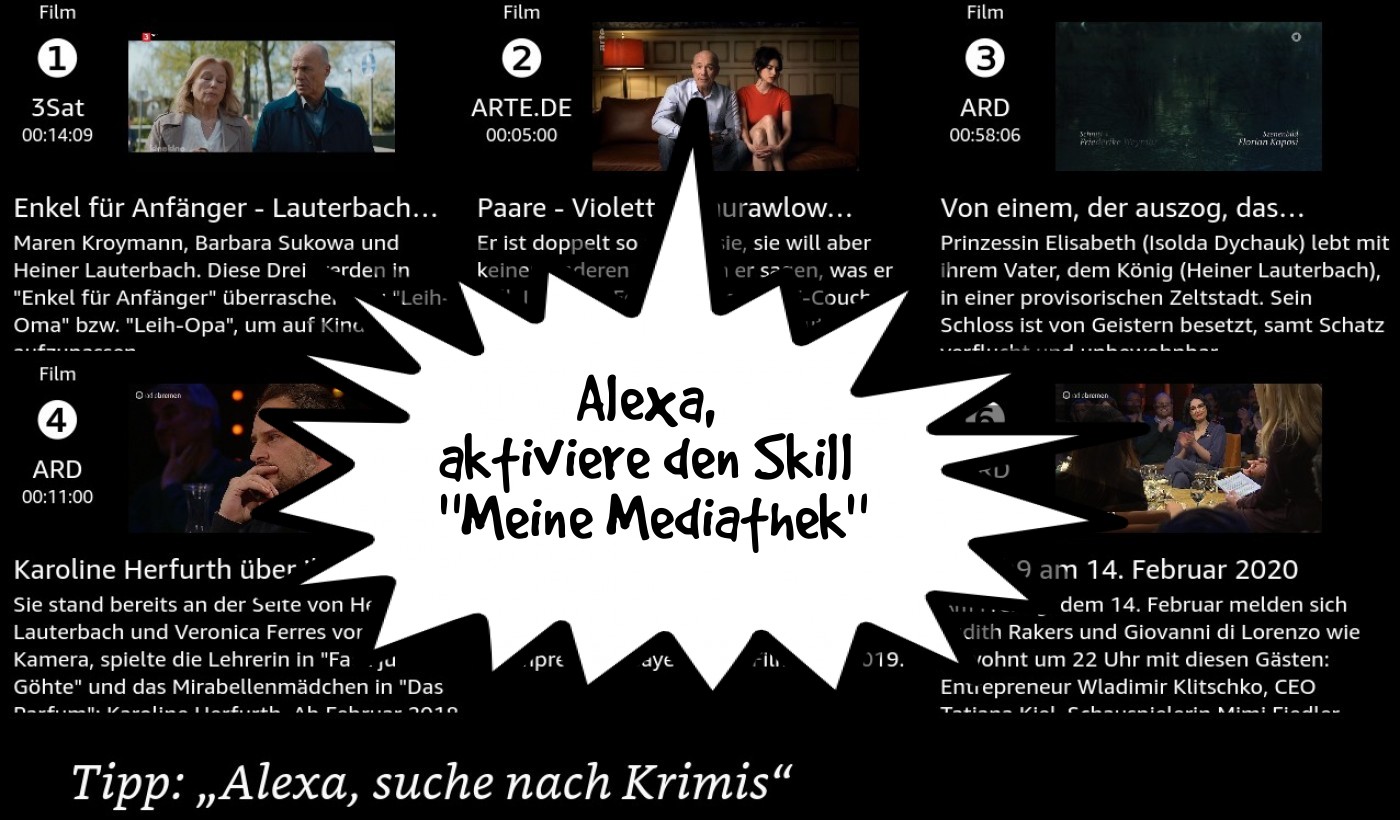

Neuer Alexa Skill “ShowTime!”

Der Alexa Skill “ShowTime!“ ist eine spezielle Version von dem Skill “Meine Mediathek“, die für den Zugriff auf Sendungen über die Themen Live-Konzert, Kabarett und Theater optimiert ist. Höchstwahrscheinlich irrelevante Beiträge wie Nachrichtensendungen werden aus den Ergebnislisten herausgefiltert, besonders lange Beiträge bevorzugt dargestellt.

Mehr über diesen Skill erfahrt Ihr hier.

Neuer Alexa Skill “Power Booster”

Der Alexa Skill “Power Booster“ schenkt Dir einen kurzen Moment Entspannung, um Deine Batterien wieder aufzuladen. Benötigt wird ein Gerät mit Bildschirm. Einfach mal ausprobieren: danach fühlst Du Dich garantiert besser!

- 🇩🇪 https://www.amazon.de/gp/product/B08W5BD7P7 (de-DE)

- 🇺🇸 https://www.amazon.com/gp/product/B08W5BD7P7 (en-US)

- 🇬🇧 https://www.amazon.co.uk/gp/product/B08W5BD7P7 (en-GB)

- 🇨🇦 https://www.amazon.ca/gp/product/B08W5BD7P7 (en-CA)

- 🇮🇳 https://www.amazon.in/gp/product/B08W5BD7P7 (en-IN)

- 🇦🇺 https://www.amazon.com.au/gp/product/B08W5BD7P7 (en-AU)

“VoiceLunch for Developers” zum Thema “Bixby”

Beim ersten VoiceLunch for Developers erzählt uns Roger Kibbe etwas über Bixby. Wir haben viel gelernt in einer Stunde und es blieb noch Zeit, um Fragen zu stellen. Zwei Handys von Samsung wurden am Ende auch noch verlost - aber die haben schließlich andere Teilnehmer bekommen.

Wer in Zukunft keinen VoiceLunch-Termin verpassen möchte, der kann sich hier anmelden

Neuer Alexa Skill “Rosenzeit”

Der Alexa Skill “Rosenzeit“ ist eine spezielle Version von dem Skill “Meine Mediathek“, die für den Zugriff auf Sendungen über die Themen Herz & Schmerz & Schlager optimiert ist. Höchstwahrscheinlich irrelevante Beiträge wie Nachrichtensendungen werden aus den Ergebnislisten herausgefiltert.

Mehr über diesen Skill erfahrt Ihr hier.

Neuer Alexa Skill “Naturzeit”

Der Alexa Skill “Naturzeit“ ist eine spezielle Version von dem Skill “Meine Mediathek“, die für den Zugriff auf Sendungen über die Themen Erde, Natur und Tierwelt optimiert ist. Höchstwahrscheinlich irrelevante Beiträge wie Nachrichtensendungen werden aus den Ergebnislisten herausgefiltert, der Sender KiKa wird nicht berücksichtigt.

Mehr über diesen Skill erfahrt Ihr hier.

Zweiter Platz bei Hackathon für Smart Speaker der DT

Darüber habe ich mich gefreut: nach 16 Tagen und mehreren Auswahlrunden hat die Jury beim Hackathon “Remote Rhapsody“ für den Smart Speaker “Hallo Magenta“ der Deutschen Telekom meinen Beitrag “Virtual Help Desk“ auf den zweiten Platz gewählt.

Eine Beschreibung des Projekts inklusive Präsentation und Quelltext können auf “github“ eingesehen werden.

Neuer Alexa Skill “Raumzeit”

Der Alexa Skill “Raumzeit“ ist eine spezielle Version von dem Skill “Meine Mediathek“, die für den Zugriff auf Sendungen über die Themen Geschichte, Schience und Fiction optimiert ist. Höchstwahrscheinlich irrelevante Beiträge wie Nachrichtensendungen werden aus den Ergebnislisten herausgefiltert, der Sender KiKa wird nicht berücksichtigt.

Mehr über diesen Skill erfahrt Ihr hier.

Smart Speaker “Hallo Magenta” der Deutschen Telekom (DT)

Durch meine Teilnahme beim Hackathon “Remote Rhapsody“ hatte ich ausführlich Gelegenheit, mich intensiv mit dem Smart Speaker “Hallo Magenta“ der Deutschen Telekom zu beschäftigen.

Durch die Brille eines Alexa-Entwicklers gesehen sind mir die folgenden Punkte aufgefallen:

Für Custom Skills ist kein “Invocation Name” erforderlich, da im Hintergrund mit einem einheitlichen großen Sprachmodell gearbeitet wird. Das Trainieren dieses Modells dauert lange und es drohen Seiteneffekte, wenn ein neuer Skill dazu kommt. Deshalb bin ich etwas skeptisch, inwiefern dieser Ansatz gut skalieren kann, wenn mehr und mehr Skills dazu kommen. Für den Anwender ist es aber natürlich eine tolle Sache, wenn er sich den Namen eines Skills nicht mehr merken muss und er einfach danach fragen kann, was ihn interessiert.

Es gibt vordefinierte Domänenmodelle zum Beispiel für Wetter-Skills. Mehrere Custom Skills können so ein und dasselbe Domänenmodell implementieren und der Benutzer hat dann die Wahl, welchen Skill er zum Beispiel zum Thema “Wetter” einsetzen möchte.

Das macht es möglich, so etwas zu fragen wie “Magenta, wie wird das Wetter in München?“ statt “Magenta, frage Big Sky wie wird das Wetter in München?“.

Ein eingebauter DECT Chip macht es möglich, das Gerät mit einem Telefon-Router zu verknüpfen. Bei mir hat es mit einer FritzBox erfolgreich funktioniert. Damit ist es mir möglich, per Sprachbefehl ein Telefongespräch anzustoßen oder einen Anruf auf meiner Festnetznummer entgegenzunehmen.

Eine API für Telefonie macht es möglich, native Anrufe auch von einem Skill aus anzustoßen. Ein möglicher Anwendungsfall ist zum Beispiel ein Help Desk Skill, der den Benutzer nach seiner Situation fragt und dann einen Anruf zu einer passenden Hotline auslöst.

Alexa ist in die Geräte “eingebaut”. Abhängig vom Wake-Word werden die Requests zu unterschiedlichen Endpunkten weiter geleitet.

Ein LevelFür die Implementierung von Custom Skills ist ein Python SDK verfügbar (es soll auch ein JAVA API existieren, das habe ich aber nicht testen können). Das SDK nimmt einem die Arbeit mit der JSON-Kommunikation zwischen Gerät und Skill ab. Ein SDK für Node.JS ist (noch?) nicht verfügbar.

Um einen Custom Skill zum Laufen zu bringen, muss manuell mit unterschiedlichen Artefakten (Code und JSON)hantiert werden. Eine einheitliche Oberfläche, wie wir sie im Zusammenhang mit Alexa Hosted Skills kennen, existiert für Magenta derzeit nicht

Eine Integration in Visual Studio Code existiert nicht.

Der Skill kann irgendwo gehostet werden, so lange er nur über eine öffentliche URL erreichbar ist.

Besser als bei Alexa: Die Companion App unterstützt “Cards”, bei denen URLs angeklickt werden können.

Zum Testen existiert ein Command Line Tool, mit dem ein “Chat” mit dem eigenen Skill ermöglicht wird.

Neuer Alexa Skill “Krimizeit”

Der Alexa Skill “Krimizeit“ ist eine spezielle Version von dem Skill “Meine Mediathek“, die für den Zugriff auf Krimisendungen optimiert ist. Tipps, Filter und Suchfunktion sind für diesen Zweck angepasst. Höchstwahrscheinlich irrelevante Beiträge wie Nachrichtensendungen werden aus den Ergebnislisten herausgefiltert, die Sender KiKa und Phoenix gar nicht erst berücksichtigt.

Mehr über diesen Skill erfahrt Ihr hier.

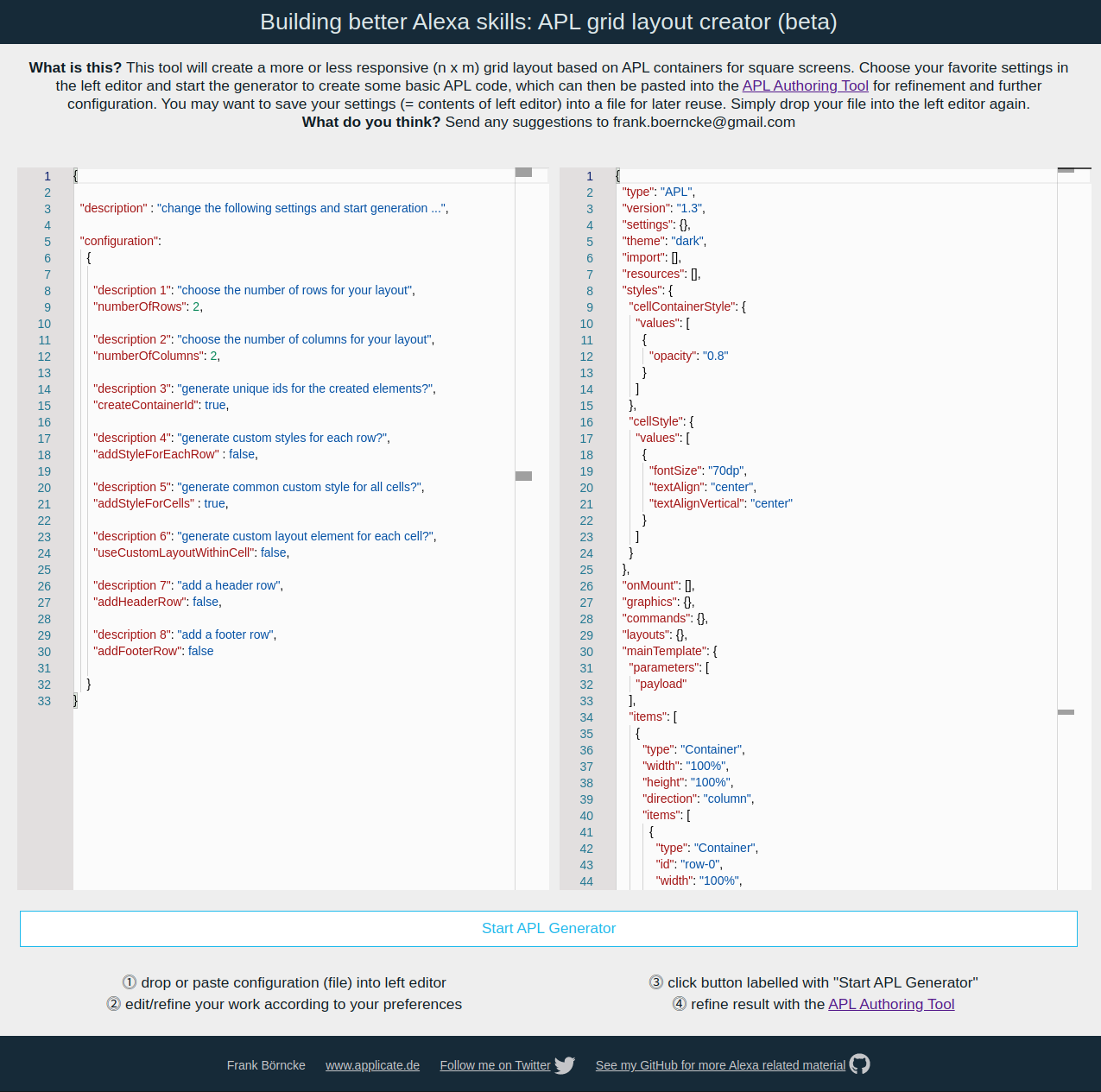

Neu: Generator für APL Grid Layout mit Container-Elementen

Immer wieder stehe ich vor der Aufgabe, mit den Containerlementen von APL eine Gitterstruktur aufbauen zu müssen. Da das wenig Spaß macht, habe ich einen Generator geschrieben, der den langweiligen Teil dieser Arbeit übernimmt. Danach bleibt dann mehr Zeit übrig, sich um den interessanten Teil der Arbeit zu kümmern.